SepLLM – 分隔符压缩加速大语言模型的高效框架

SepLLM简介

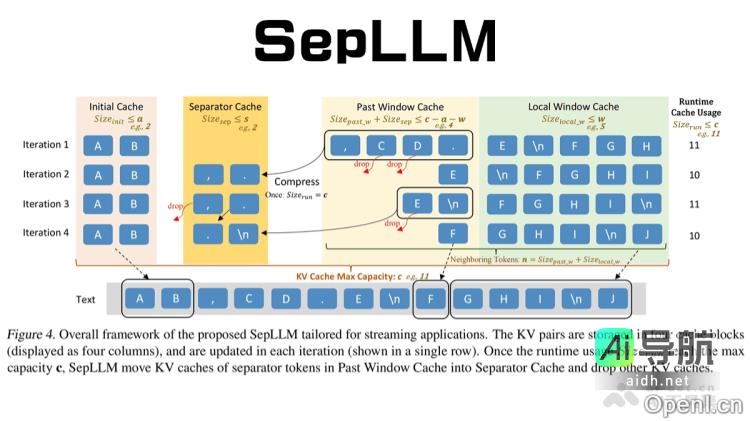

SepLLM是香港大学和华为诺亚方舟实验室等机构共同研发的高效框架,旨在加速大型语言模型(LLM)的推理过程。SepLLM通过有效地压缩段落信息并消除冗余标记,显著提高了模型的推理速度和计算效率。该框架的关键创新在于利用分隔符(如标点符号)的注意力机制,将段落信息紧凑地存储在这些标记中,从而减轻计算负担。在处理长序列(如400万个标记)时,SepLLM表现出色,成功地维持了低困惑度和高效率。此外,SepLLM支持多节点分布式训练,并整合了多种加速操作(如fused rope和fused layer norm)。

SepLLM的主要功能

- 长文本处理能力:SepLLM能够高效地处理超过400万个标记,特别适用于需要保持上下文连贯性的任务,如文档摘要和长对话。

- 推理与内存效率提升:在GSM8K-CoT基准测试中,SepLLM降低了50%以上的KV缓存使用量,减少了28%的计算成本,缩短了26%的训练时间,并显著提升了推理速度。

- 多场景部署灵活性:SepLLM支持从头训练、微调以及流式应用等多种部署方式,能够无缝结合预训练模型。

- 支持多节点分布式训练:该框架的代码库支持高效的多节点分布式训练,并整合了多种加速训练的操作(如fused rope和fused layer norm等)。

SepLLM的技术原理

- 稀疏注意力机制:SepLLM专注于三类标记,利用mask矩阵和注意力范围的限制,在自注意力层中仅计算这三类标记之间的注意力,以实现稀疏化。

- 初始标记:作为注意力的锚点的序列开头标记。

- 邻近标记:用于维持局部语义连贯性的当前标记附近的标记。

- 分隔符标记:如逗号、句号等,用于压缩存储段落信息。

- 动态KV缓存管理:SepLLM设计了初始缓存、分隔符缓存、历史窗口缓存和局部窗口缓存等专门的缓存块。通过周期性的压缩和更新策略,SepLLM可以有效处理长序列,同时减少KV缓存的使用。

SepLLM的项目地址

- 项目官网:https://sepllm.github.io/

- Github仓库:https://github.com/HKUDS/SepLLM

- arXiv技术论文:https://arxiv.org/pdf/2412.12094

SepLLM的应用场景

- 流式应用:适用于多轮对话和实时文本生成等流式场景,支持无限长度的输入,同时保持高效的语言建模能力。

- 推理与内存优化:通过减少KV缓存和计算成本,适合资源有限的环境(如边缘计算和移动设备),从而降低部署成本。

- 工业应用:在大规模商业应用中,降低部署成本,提升服务效率,支持高并发请求。

- 研究与创新:为优化注意力机制提供新思路,支持多语言、特定领域优化以及硬件适配等研究方向。

常见问题

- SepLLM适合哪些应用场景? SepLLM特别适用于需要处理长文本和高效推理的应用场景,如文档摘要、对话系统等。

- 如何获取SepLLM? 用户可以访问SepLLM的官方网站或Github仓库下载相关资源和文档。

- SepLLM的性能如何? 在多项基准测试中,SepLLM展现了显著的性能提升,包括降低计算成本和提高推理速度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...