DiffRhythm是由西北工业大学与香港中文大学(深圙)联合研发的一款先进的端到端音乐生成工具。它基于潜扩散模型技术,可快速生成包含人声和伴奏的完整音乐作品。用户只需输入歌词和风格提示,DiffRhythm就能在短短10秒内创作出最长达4分45秒的高质量音乐,显著提高了音乐创作效率,解决了传统生成工具耗时长、生成片段的问题。生成的音乐在旋律和歌词表达方面展现出极高的音乐性与可理解性。

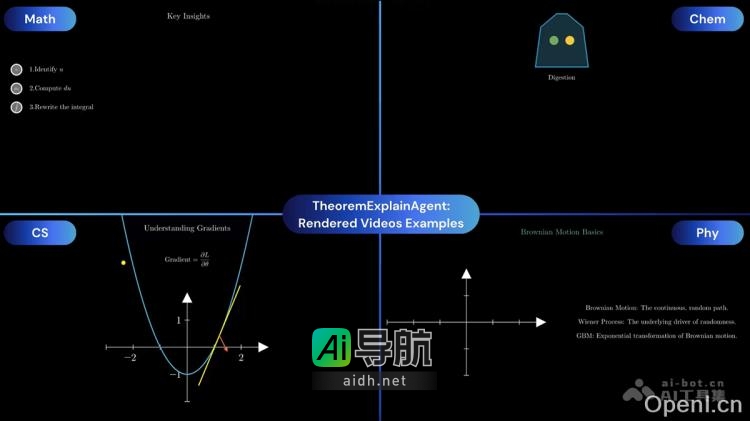

DiffRhythm的主要功能包括快速生成完整音乐、歌词驱动的创作、高质量音乐输出、灵活的风格定制、开源与可扩展性、创新的歌词对齐技术以及文本条件与多模态理解。该工具利用潜扩散模型进行音乐生成,包含前向加噪和反向去噪两个阶段;采用自编码器结构,以变分自编码器对音频数据进行处理;以及采用非自回归结构和扩散变换器实现高效的音乐生成。DiffRhythm还提供完整的训练代码与预训练模型,支持用户二次创作。

该项目地址包括官网、Github仓库、HuggingFace模型库和arXiv技术论文。应用场景涵盖音乐创作辅助、影视视频配乐、教育研究以及音乐人与个人创作等领域。DiffRhythm支持多语言歌词输入,音乐质量优秀,操作简便,用户不需要专业技术背景即可使用。DiffRhythm是开源的,用户可以根据需求进行个性化开发。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...