VLM-R1是浙江大学Om AI Lab推出的一款视觉语言模型,采用强化学习技术。该模型可以根据自然语言指令精确定位图像中的目标物体,例如根据描述”图中红色的杯子”找到对应图像区域。VLM-R1建立在Qwen2.5-VL架构基础上,结合了DeepSeek的R1方法,通过强化学习优化与监督微调(SFT)来增强模型的稳定性和泛化能力。此模型在复杂场景和跨域数据上表现出色,能够深入理解视觉内容并生成准确的指代表达。

VLM-R1是一款先进的视觉语言模型,旨在通过自然语言指令精确定位图像中的目标物体。它基于Qwen2.5-VL架构,结合了强化学习和深度学习最新进展,实现了在复杂场景中的高效表现。VLM-R1具有强大的泛化能力,能够理解多样的视觉内容并生成精确的响应。

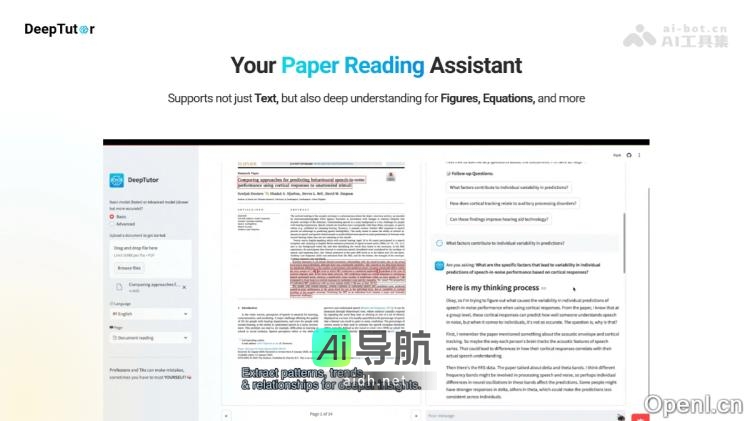

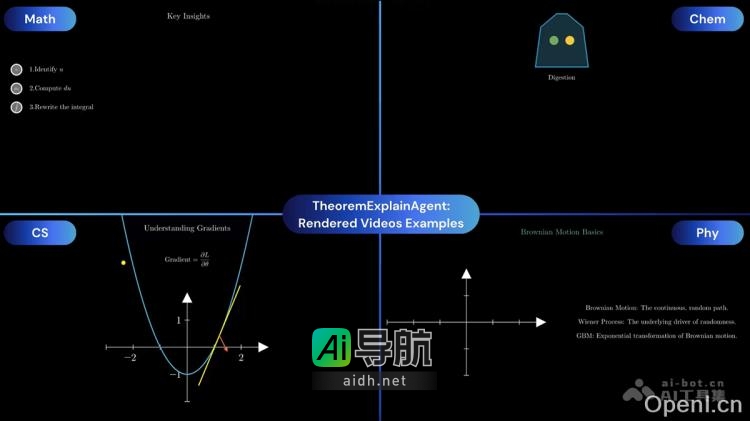

VLM-R1的主要功能包括指代表达理解(REC)、图像与文本联合处理、强化学习优化、高效训练与推理、多模态推理与知识生成、易用性与开源性。其中,采用了GRPO(Group Relative Policy Optimization)技术以提升模型在复杂场景中的表现,并支持在单个GPU上训练大规模参数模型。此外,VLM-R1还具备较强的泛化能力和稳定性,并且基于Qwen2.5-VL架构开发,使其在多种复杂场景中能够保持高效和稳定的性能。

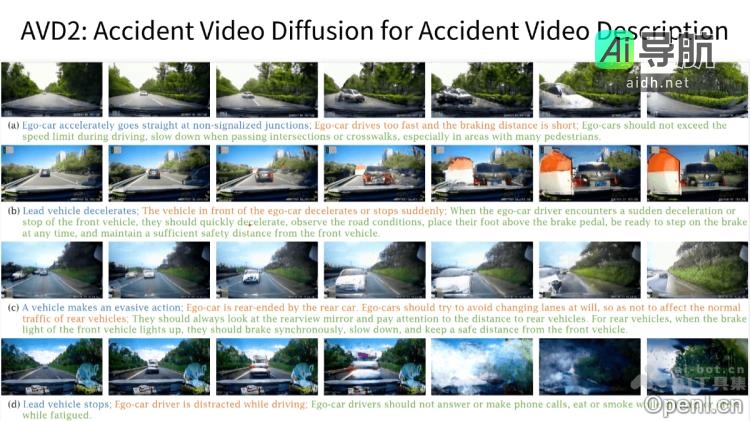

VLM-R1的项目地址包括Github仓库(https://github.com/om-ai-lab/VLM-R1)和在线体验Demo(https://huggingface.co/spaces/omlab/VLM-R1)。该模型的应用场景涵盖智能助理与交互、无障碍辅助技术、自动驾驶与智能交通、医疗影像分析、智能家居与物联网等领域。同时,VLM-R1支持同时输入图像和文本进行交互,并具有高效的训练与推理能力。

对于常见问题,VLM-R1支持同时输入图像和文本进行交互,开发者可以通过访问官方GitHub仓库获取完整的训练和评估流程,快速上手。此外,VLM-R1采用Flash Attention等技术提高了计算效率,可在单GPU上处理大规模模型。

文章中提到的AI工具

深度求索:引领未来人工智能技术的探索与创新

相关AI热点