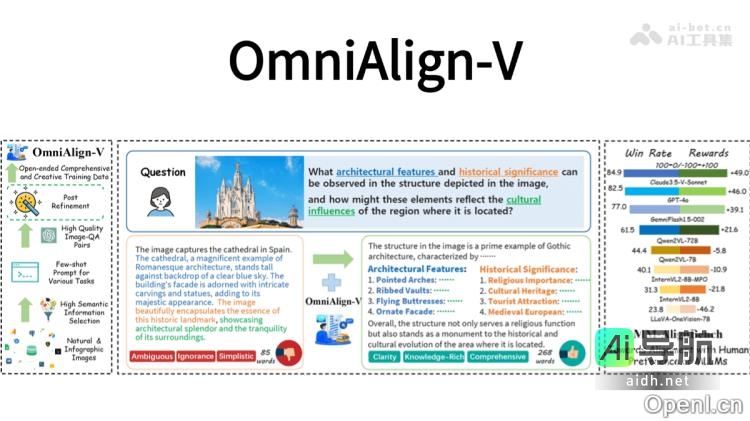

OmniAlign-V是由上海交通大学、上海AI Lab、学、复旦大学和浙江大合合作推出的高质量多模态数据集,旨在增强多模态大语言模型(MLLMs)与人类偏好之间的对齐能力。该数据集包含约20万个多模态训练样本,涵盖自然图像和信息图表,并结合开放式、知识丰富的问题与答案。

OmniAlign-V的主要目的是帮助多模态大语言模型更好地理解人类需求和偏好。通过设计包含多样化任务的数据集,如知识问答、推理和创造性任务,以提升模型对齐能力。此外,OmniAlign-V引入了图像筛选策略,确保训练样本中的图像具有丰富且复杂的语义。

这一数据集的关键功能包括提供高质量的多模态训练数据、增强开放式问答能力、提升推理和创造性能力、优化多模态指令调优以及支持多模态模型的持续优化。通过监督微调和直接偏好优化等方式,OmniAlign-V旨在提高模型在多模态交互中的对齐能力。

OmniAlign-V的技术原理涉及图像的筛选和分类、任务设计与数据生成、后处理优化、多模态训练与优化以及基准测试与评估。这些技术原理确保了数据集的多样性和高质量,并提升了模型在真实场景中的表现。

OmniAlign-V的项目地址包括项目官网、GitHub仓库、HuggingFace模型库和arXiv技术论文网址,用户可获取更多关于该数据集的详细信息。

在应用场景方面,OmniAlign-V可应用于多模态对话系统、图像辅助问答、创意内容生成、教育与学习辅助以及信息图表解读等领域,为用户提供更智能和精准的服务。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

没有相关内容!

暂无评论...