Migician是由北京交通大学、华中科技大学和清华大学的研究团队联合开发的多模态大语言模型(MLLM),旨在应对形式的多图像定位(Multi-Image Grounding,MIG)任务。该模型基于大规模训练数据集MGrounding-630k,能够根据不同形式的查询(如文本描述、图像或两者结合)在多幅图像中识别并精确定位相关视觉区域。Migician通过两阶段训练方法,结合了多图像理解和单图像定位的能力,实现在复杂视觉场景中的高效应用,推动了多模态模型在细粒度视觉定位方面的进展。

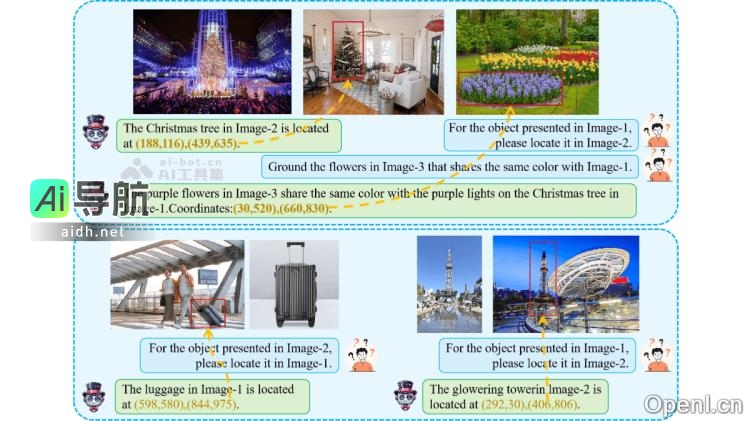

Migician的主要功能包括跨图像定位,在多幅图像中精确查找与查询相关的对象或区域,并提供其确切位置;支持多种查询方式,包括文本、图像或两者的组合;能够处理多种与多图像相关的任务,包括对象跟踪、差异识别和共同对象定位等;利用端到端的模型设计,在多图像场景中进行推理,避免了传统方法中多步骤推理带来的复杂性和错误传播问题。

技术原理方面,Migician采用端到端的多图像定位框架,直接处理多图像定位任务,省去任务分解为多个子任务的复杂性和效率问题;利用大规模指令调优数据集MGrounding-630k,学习多种任务类型的多图像定位能力;采用两阶段训练方法,在不同阶段提升模型的复杂查询下的定位能力;结合多模态融合与推理,处理抽象的视觉语义信息,如对比、相似性或功能关联来定位目标对象;并采用模型合并技术优化整体性能。

Migician的应用场景涵盖自动驾驶、安防监控、机器人交互、图像编辑和医疗影像等多个领域。它可以用于快速识别车辆周围的目标、异常行为的监控、机器人执行抓取任务、图像编辑中的对象替换、医疗影像中病变区域的定位等。

想要获取更多关于Migician的信息,您可以访问其项目官网、GitHub仓库或HuggingFace模型库。如有其他疑问或需要帮助,请查看常见问题部分。

相关AI热点