随着深度学习技术的迅猛发展,Transformer模型已经成为自然语言处理领域备受关注的算法。然而,在许多应用场景中,传统的机器学习方法支持向量机(SVM)仍然具有一定优势。本文将深入探讨Transformer与SVM的特点和应用领域,并基于关键词”Transformer是SVM”进行对比研究。

首先简要介绍Transformer和SVM的原理和特点。Transformer是一种基于自注意力机制的深度神经网络,被广泛运用于机器翻译、文本生成等自然语言处理任务。相较于传统的循环神经网络,Transformer能够有效处理更长的文本序列,并具备并行计算的优势。而SVM则是一种经典的监督学习算法,通过定义超平面来实现分类任务。SVM具有良好的泛化性能和鲁棒性,适合处理小样本和高维数据。

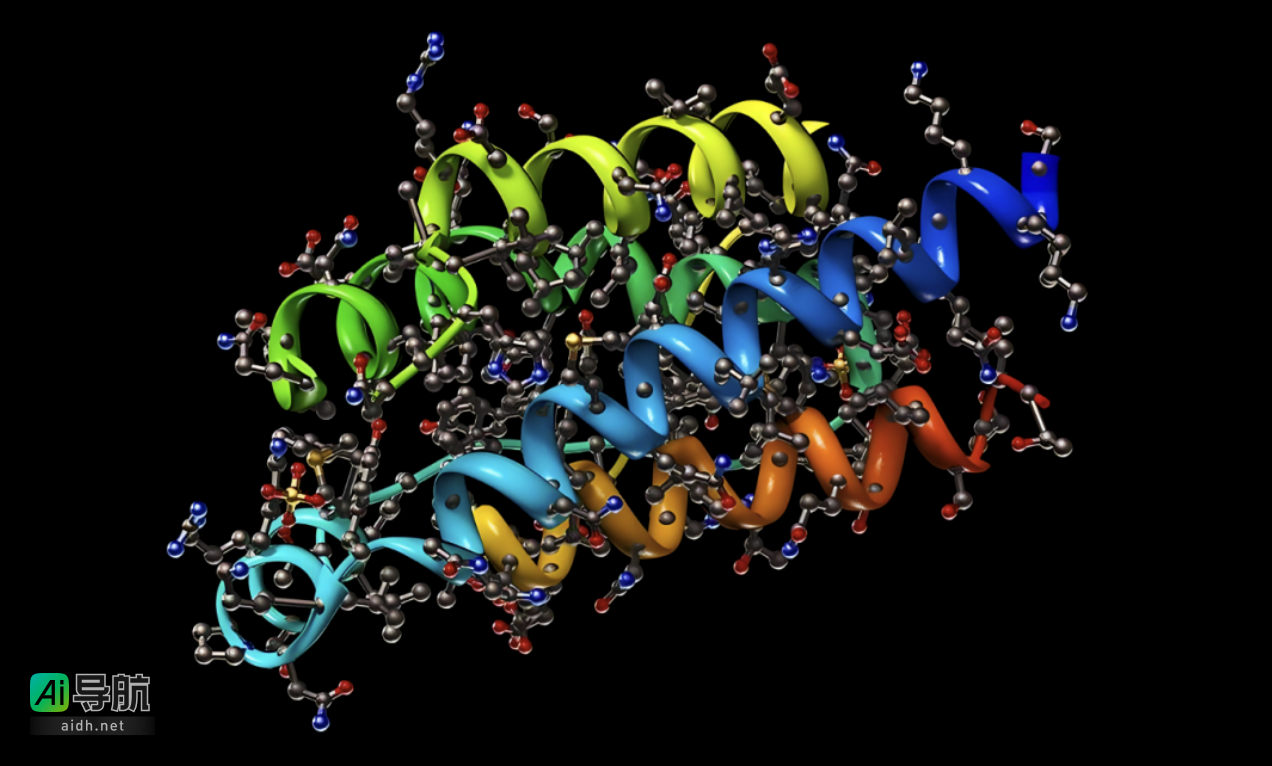

随后,我们将分析Transformer和SVM在不同领域的应用情况。在自然语言处理领域,由于Transformer具有出色的上下文建模能力,因此在机器翻译、文本摘要等任务中表现突出。然而,在一些需要大规模标注数据的应用中,SVM由于其强大的抗噪声能力仍然被广泛使用,例如文本分类、情感分析等任务。此外,SVM在图像处理和生物信息学等领域也有广泛应用,其非线性核函数能有效分类复杂样本。

在对Transformer和SVM的优劣势进行总结和对比中发现,尽管Transformer具备强大的建模能力和自适应性,但由于其较高的计算复杂度和对数据量和计算资源的要求较高,SVM表现出色在小样本和高维数据上,训练速度快且泛化性能好。然而,SVM无法直接处理序列数据,且对超参数的选择较为敏感。因此,在实际应用中,应根据具体任务和数据情况综合考虑Transformer和SVM的特点,选择最适合的算法。

通过本文对Transformer和SVM的对比研究,旨在为读者提供清晰的了解和选择依据。在选择应用Transformer或SVM时,需综合考虑任务特点、数据规模、计算资源等因素,以取得最佳性能和效果。

相关AI热点