引言

大型语言模型(LLMs)在常识理解和代码生成方面取得了显著进展,但在数学推理任务上仍然存在不足。最新的GPT-4 Code Interpreter在困难的数学推理数据集上展现了较高的性能。为了进一步提升其性能,研究人员提出了一种新的代码自我验证方法(CSV)。

研究背景

- 数学推理的挑战

尽管LLMs在多个领域表现出色,但在数学推理中,模型经常生成无意义或不准确的结果,尤其是在处理复杂计算时。

- 新模型的进展

GPT-4和PaLM-2等新一代模型在数学推理上有了显著进展,尤其是OpenAI的GPT-4 Code Interpreter,表现出较高的准确性。

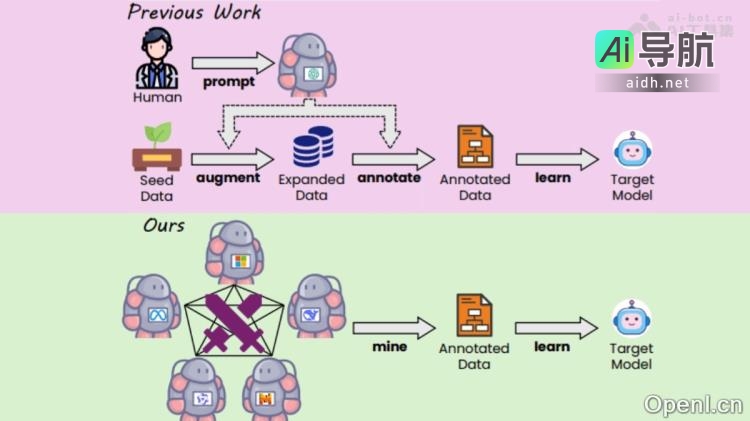

- 研究团队与方法

来自七所高校的研究人员通过引入代码使用频率的约束,探索代码生成对模型推理能力的影响。

核心发现

- 模型能力的提升

实验表明,GPT-4 Code Interpreter在生成、执行代码和评估输出方面表现出色,能够有效纠正错误。

- CSV方法的提出

基于以上发现,研究人员提出了基于代码的自我验证(CSV)方法,显著提高了数学推理的准确性。

- 自我验证机制

该方法促使模型在解题过程中使用代码进行自我验证,能够自动调整错误的解决方案,类似于人类纠错的过程。

实验设计与结果

- 提示设计

研究人员设计了三种不同的提示:

- 不允许使用代码:完全依赖自然语言推理。

- 代码只能使用一次:限制代码的使用次数。

- 无代码限制:允许多次使用代码。

- GPT-4 Code Interpreter在MATH数据集上的准确率达到了69.69%,而CSV方法的引入使准确率提升至84.3%。

- 不同提示下的代码使用频率与模型性能呈正相关,表明代码的有效使用对提高推理能力至关重要。

基于代码的自我验证(CSV)

- CSV的流程

CSV方法通过代码生成来验证答案的正确性,验证结果可以分为“真”、“假”和“不确定”三类。

- 动态调整方案

当验证结果为“错误”时,模型能够审查并调整解决方案,从而提高准确率。

- 加权多数投票机制

研究人员将验证结果集成到加权多数投票中,为不同状态分配不同权重,以提高系统的可靠性。

其他数据集的应用

- 广泛的适用性

CSV方法还在其他推理数据集上取得了优异表现,包括GSM8K、MMLU-Math和MMLU-STEM。

- 开源与闭源模型的对比

研究显示,CSV方法在开源模型上的表现优于闭源模型,研究团队也计划发布相关数据集以供进一步研究。

结论

综上所述,通过引入基于代码的自我验证方法,GPT-4的数学推理能力得到了显著提升。这一研究不仅为大型语言模型的数学推理提供了新的思路,也为未来的相关研究奠定了基础。研究人员希望通过公开数据集,进一步提升开源模型在数学推理上的表现。

文章中提到的AI工具

相关AI热点