图一:我们引入了三维意图定位(3D Intent Localization)任务,其目标为根据人类的意图描述(例如:“我想要一个能支撑背部并缓解压力的物体”),在三维场景中对目标物体进行三维边界框的检测。与此相对,现有的三维视觉定位方法则依赖于人类的推理和参考信息来进行目标检测。该示意图清楚地划分了观察与推理的执行方式:左侧是由人类手动完成,而右侧则由人工智能自动执行。

- 项目主页:https://weitaikang.github.io/Intent3D-webpage/

- 论文地址:https://arxiv.org/abs/2405.18295

- 项目代码:https://github.com/WeitaiKang/Intent3D

介绍

在现实世界中,人工智能依据自然语言指令执行目标检测是人机交互的重要组成部分。以往的研究主要集中在视觉指引(Visual Grounding)上,即在二维图像或三维场景中,根据人类提供的参照性语言定位目标物体。

然而,人类在日常生活中寻找目标物品时,往往是基于特定的意图。例如,一个人可能会说:“我想找一个能靠着的物品,以减轻背部压力”,而不是直接无缘无故地描述“找到椅子”或“找到沙发”。

什么是三维意图定位(3D-IG)?

目前,三维视觉指引(3D Visual Grounding, 3D-VG)方法依赖用户提供的明确参照信息,例如目标的类别、属性或空间关系。然而在许多现实场景中,例如当个体忙碌或存在视觉障碍时,无法提供此类参照描述。因此,使人工智能能够自动推理用户意图并检测目标物体,是更加智能和自然的交互方式。如图一所示,相比传统的3D-VG(左图),我们的3D-IG任务(右图)使得人工智能能够直接基于用户意图进行目标推理,而无需具体的物体描述。

为何选择三维而非二维?

近年来,针对意图推理的任务在二维视觉领域已有所研究,例如意图导向目标检测(Intention-Oriented Object Detection)、隐式指令理解(Implicit Instruction Understanding)等。然而,这些研究局限于二维视角,无法完整呈现现实世界的几何与空间信息。相对而言,三维数据更贴近现实世界,不仅包含深度信息,还能提供完整的物体几何特征、外观特征以及空间上下文。因此,在三维场景中进行意图推理,不仅能更准确地模拟真实需求,还能推动体智能(Embodied AI)、自动驾驶、增强现实/虚拟现实(AR/VR)等领域的发展。

数据集与基准

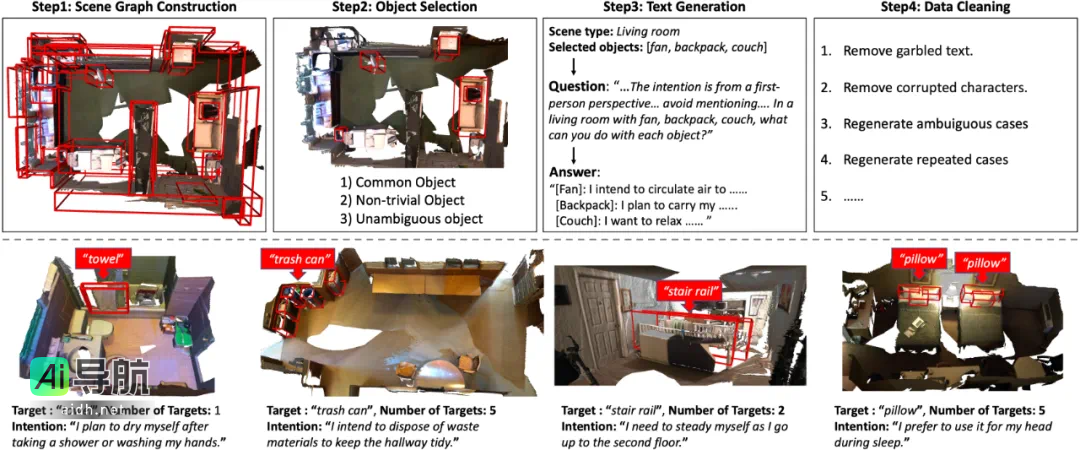

为推动三维意图定位研究,我们构建了Intent3D数据集,包含44,990条意图文本,涉及209类物体,基于1,042个ScanNet点云场景。由于意图表达的多样性,采用预定义格式进行标注会限制模型的泛化能力。此外,众包标注往往缺乏可靠性,而专业标注则成本高且难以扩展。因此,如图二所示,我们采用GPT-4生成意图文本,并经过人工质量检查,以确保高准确性与多样性。

图二:(上排)数据集构建流程图。构建场景图后,我们根据三个标准选择目标物体:常见物体、非平凡物体及无歧义物体。我们利用ChatGPT依据设计提示生成意图文本,最后手动清理数据。(下排)我们数据集中针对不同目标数量和文本长度的示例。

此外,为充分评估我们在此领域的研究能力,我们利用三种主要的基于语言的三维目标检测技术构建了几个基准。这包括使用下述模型对此数据集进行评估:专门为三维视觉定位设计的专家模型(BUTD-DETR, EDA)、为通用三维理解任务制定的基模型(3D-VisTA)以及基于大型语言模型(LLM)的模型(Chat-3D-v2)。我们采用多种设置评估这些基线,包括从头训练、微调和零样本评估。

方法

如何解决三维意图定位问题?

如图三所示,我们设计了一种新方法IntentNet,结合多个关键技术:

- 动宾对齐(Verb-Object Alignment):首先识别意图中的动词,并与对应的宾语特征进行对齐,从而提升意图理解的准确性。

- 候选框匹配(Candidate Box Matching):在稀疏三维点云中明确匹配候选目标框,以提高多模态意图推理的能力。

- 级联自适应学习(Cascaded Adaptive Learning):依据不同损失函数的优先级,自适应调整损失函数权重,提升模型性能。

图三:IntentNet:(骨干网络)使用PointNet++提取点特征;MLP编码三维目标检测器预测框;

时,查询(query)被训练以识别动词(损失 L_vPos)、与动词进行对齐(损失 L_vSem)以及与宾语对齐(损失 L_voSem)。

实验结果

通过显式建模意图语言理解和推理,我们的 IntentNet 在性能上显著优于以往的所有方法。在验证集上,相较于排行第二的方法,我们在 Top1-Acc@0.25 和 Top1-Acc@0.5 中分别实现了 11.22% 和 8.05% 的性能提升。同时,我们在 AP@0.25 和 AP@0.5 上分别提高了 9.12% 和 5.43%。在测试集上,我们同样实现了不同程度的改进,具体表现为在 Top1-Acc@0.25 和 Top1-Acc@0.5 中分别达到了 11.06% 和 10.84%,而在 AP@0.25 和 AP@0.5 中的改进幅度亦达到了 6.72% 和 5.6%。

相关AI热点