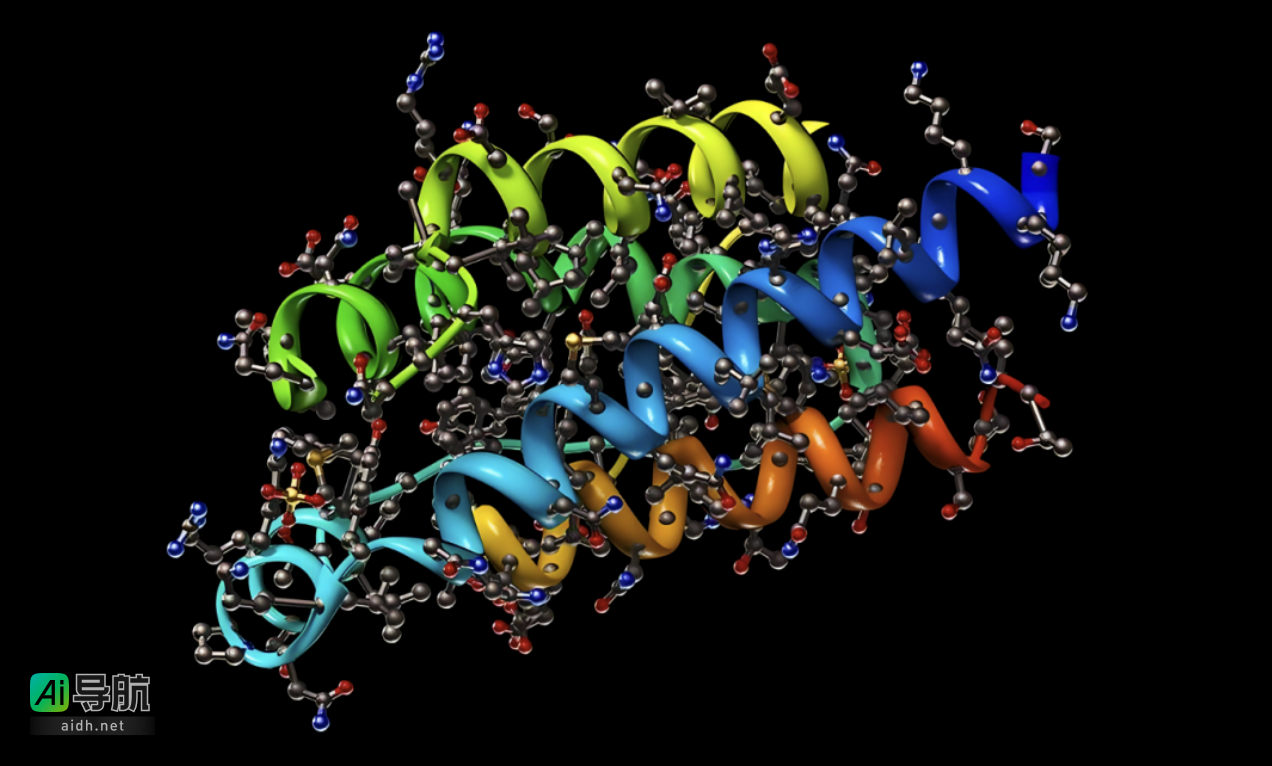

神经网络是一种模拟人脑神经系统的计算模型,通过多个层次的神经元相互连接来执行各种机器学习任务。在神经网络结构中,隐含层位于输入层和输出层之间,其数量对模型的性能具有重要影响。

选取适当的隐含层数量是神经网络模型设计中的关键之一。合理的隐含层数量可有效提升模型的性能和准确度。首先,隐含层数量决定了模型的学习能力。较少的隐含层可能表示模型的拟合能力不足,无法捕捉到复杂的数据关系;而过多的隐含层则可能导致模型出现过拟合,过度拟合数据。因此,根据任务复杂性和数据集规模,需要做出合理选择。

隐含层数量的选择也影响模型的训练效率。较少的隐含层数量可降低模型复杂度,加快训练速度;而过多的隐含层可能导致训练时间延长,甚至无法达到收敛。因此,在实际应用中,需在模型性能和训练效率之间取得平衡,选取适当的隐含层数量。

解决神经网络隐含层数量选择问题的方法通常有几种。首先是经验法,利用实践经验和先前研究结果确定隐含层数量的范围。其次是启发式算法,如遗传算法、模拟退火等,通过迭代搜索来找到最佳的隐含层数量。另一种常用方法是使用交叉验证,将数据集划分为训练集和验证集,通过模型在验证集上的表现选择最佳的隐含层数量。

神经网络的隐含层数量对模型性能具有重要影响。根据具体任务的复杂性和数据集规模,权衡模型性能和训练效率,选择合适的隐含层数量。通过经验法、启发式算法或交叉验证等方法,可找到最佳的隐含层数量,提高模型性能和准确度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...