艾伦人工智能研究所(AI2)近日发布了大型语言模型OLMo2 32B,其完全开放的特性使其在众多闭源模型中脱颖 […]

艾伦人工智能研究所(AI2)近日发布了大型语言模型OLMo2 32B,其完全开放的特性使其在众多闭源模型中脱颖而出。 该模型不仅是OLMo2系列的最新成果,更以其开放的数据、代码、权重和训练过程,为人工智能领域的研究和创新提供了一个全新的合作模式。

OLMo2 32B最显著的特点在于其彻底的开源属性。这与许多闭源模型形成鲜明对比,AI2 此举旨在促进更广泛的研究与创新,鼓励全球研究人员共同进步。

320亿参数:性能超越GPT-3.5 Turbo

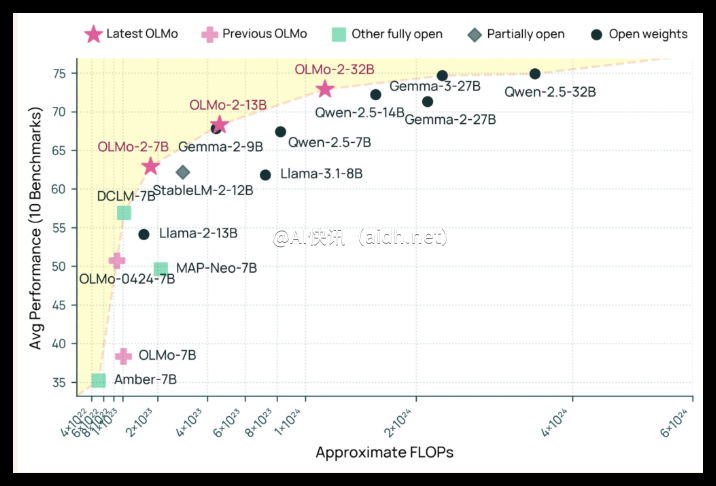

OLMo2 32B拥有320亿参数,规模显著提升。在多项标准学术基准测试中,其性能甚至超越了GPT-3.5 Turbo和GPT-4o mini,有力证明了开源模型也能达到顶尖水平,并非只有资源雄厚的机构才能取得突破。

OLMo2 32B的优异性能源于其精细的训练过程,包括预训练和中期训练两个阶段。预训练阶段使用了约3.9万亿tokens的数据集,涵盖DCLM、Dolma、Starcoder和Proof Pile II等多个来源;中期训练则集中于包含8430亿tokens的Dolmino数据集,重点提升模型在教育、数学和学术领域的理解能力。这种分阶段、有针对性的训练策略确保了模型具备扎实的语言功底。

高效率:低算力,高性能

除了性能卓越,OLMo2 32B还在训练效率方面表现出色。它在达到与领先开放权重模型相当的性能的同时,仅使用了大约三分之一的计算资源,远低于Qwen2.5 32B等模型。 这体现了AI2在资源高效AI开发方面的技术实力,预示着未来更多“平民级”的强大AI模型将成为可能。

OLMo2 32B的发布是开放、可访问人工智能发展道路上的一个重要里程碑。它为研究人员提供了一个性能媲美甚至超越部分专有模型的完全开放方案,证明了周全的设计和高效的训练方法能够带来突破性进展。 这种开放性将鼓励全球范围内的合作,共同推动人工智能领域的进步,造福全人类。

OLMo2 32B的出现将为AI研究注入新的活力,降低研究门槛,促进更广泛的合作,并展现出一种更具活力和创新性的AI发展路径。 这或许也为那些坚持闭源策略的AI巨头们提供了一个新的思考方向:拥抱开放,才能赢得更广阔的未来。

资源链接:

快讯中提到的AI工具

机器学习和人工智能技术的平台

OpenAI 推出的最新小型模型

OpenAI 最新的旗舰模型

OpenAI 发布的最新一代语言模型