当前,人工智能模型(LLM)在各个领域展现出强大的能力,例如写作、编码和创造等,这令人惊叹不已!那么,您是否准 […]

当前,人工智能模型(LLM)在各个领域展现出强大的能力,例如写作、编码和创造等,这令人惊叹不已!那么,您是否准备好了迎接“大型”AI模型的时代?让我们一起深入了解这些尖端技术背后的奥秘,共同探索未来。

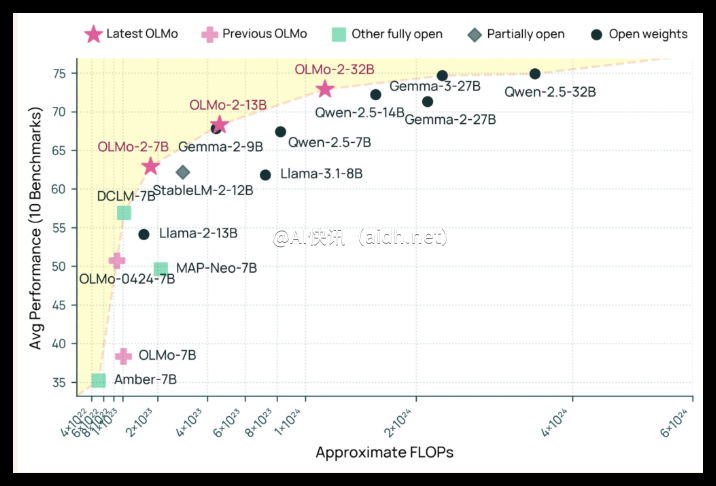

总的来说,LLM技术正在逐步克服阻碍其更广泛应用的“瓶颈”问题:一方面,是缺乏足够开放的模型,难以避免商业限制;另一方面,是硬件资源成本高昂,使得难以实施大规模部署,并创造出具备“生成型人工智能加速器”特点的创新!为此,涌现出了一系列开源项目,旨在促进更大范围的实验和研究。

业界已经涌现出众多杰出的开源模型,比如 Llama3、Pythia 以及 GPT-J 等知名的 LLM 解决方案。值得关注的是,LLM 模型中用于提升模型性能的“秘诀”已经逐渐被公开,例如用于提升生成效果的“微调技术”,使得更多的开发者能够深入探索相关领域的实践应用。 此外,一种关键性的技术是,一个 LLM 可以利用更多的数据来学习“更多的知识”,另一个 LLM 则专注于高效提炼关键信息。

针对“微调技术”而言,LLM 可以通过调整其内部参数来适应特定的任务需求,从而显著提升特定领域的性能。 比如,可以优化生成文本的流畅度,并提高生成内容的质量,从而更好地满足“定制化”的应用场景。 针对另一种情况,通过增强专业领域的技能,可以显著改善特定任务的表现,实现更高效的“垂直领域优化”。

鉴于“生成型人工智能加速器”的创新已融入 LLM 蓬勃发展的浪潮之中,其显著提升了现有模型的能力,并推动了相关领域的创新。目前,人们正在积极探索通用模型的构建策略,致力于实现更高的性能表现。 因此,LLM 的技术突破为人工智能发展带来了新的可能性,并有潜力演变为“智能应用的基石”。

总而言之,LLM 技术持续进步的驱动力源于对技术瓶颈的突破,有助于释放 LLM 的巨大潜力。 业界同仁正在努力构建更加强大且高效的解决方案,为人工智能的未来发展奠定坚实的基础,并期待由此催生出“颠覆性创新”。

参考链接:https://arxiv.org/pdf/2410.21272