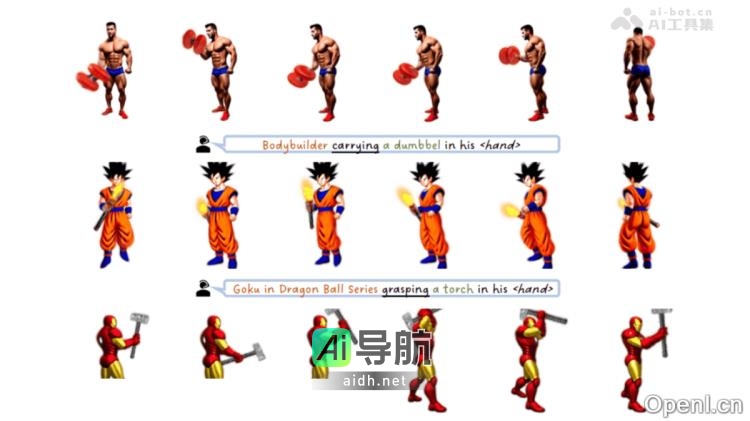

AvatarGO是南洋理工大学S-Lab、上海AI Lab和香港大学联合开发的创新框架,旨在通过文本描述直接生成可动画化的4D人体与物体交互场景。AvatarGO采用零样本方法,并基于预训练的扩散模型,解决了传统技术在生成日常人机交互(HOI)场景时面临的挑战。其核心技术包括LLM引导的接触重定位和优化功能,可以确保生成的动画准确、流畅,且避免穿透现象。

AvatarGO的主要功能包括文本生成4D交互场景、精确接触表示、解决穿透问题、多样化4D动画生成和支持多种人物与物体组合。其技术原理涉及LLM引导的接触重定位、空间感知的分数蒸馏采样、对应关系感知的优化以及基于扩散模型的3D和4D生成。

该项目的应用场景包括虚拟导购员、展厅讲解员、数字大堂经理、车载虚拟助手以及VR/AR内容创作等领域。详细信息可以在项目官网、GitHub仓库和arXiv技术论文上获取。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

没有相关内容!

暂无评论...