文章概述

本文讨论了34亿参数的Code Llama模型在M2 Ultra Mac上运行的表现及其背后的技术原理,特别是投机采样(Speculative Sampling)技术如何加速推理过程。文章强调了这一技术的潜在优势和应用场景,并借助专家评论增强了论点的权威性。

Code Llama模型的性能

- 运行环境:Code Llama模型可以在M2 Ultra上以F16精度运行。

- 推理速度:在该环境下,推理速度达到每秒20个token,远超其他需要多个高端GPU的模型。

- 技术突破:这一成就的核心在于投机采样技术,这一方法不仅提升了速度,也在AI圈内引发了广泛讨论。

投机采样的原理

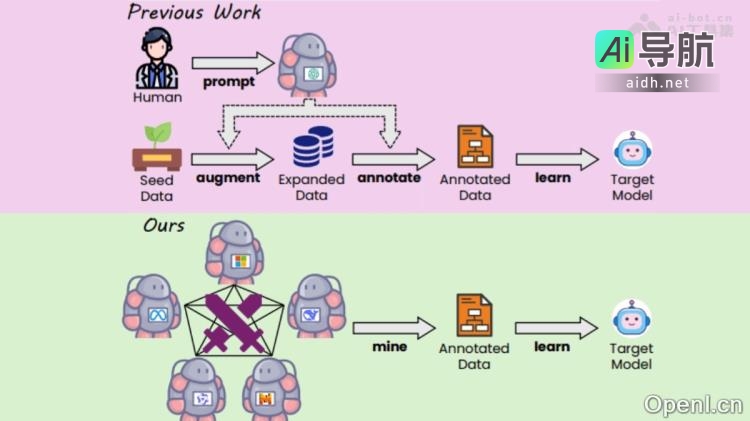

投机采样是一种新型的推理优化技术,其核心理念是通过使用一个小模型生成草稿,再由一个大模型进行校验和修正。具体步骤如下:

- 草稿生成:使用较小的模型(如Q4 7B quantum)生成初步的token序列。

- 模型校验:将生成的草稿序列输入到大模型(如34B Code Llama)中进行校验。

- 加速推理:通过这种方式,可以在不牺牲准确度的情况下,显著提高推理速度。

投机采样的优势

- 速度提升:在使用投机采样后,推理速度可达每秒20 token,相较于未使用该技术的情况下,速度提升显著。

- 内容生成的有效性:在代码生成任务中,草稿模型通常能准确预测大部分token,因此整体生成效果良好。

- 适用性广泛:除了代码生成,投机采样在其他语言生成任务中也可能带来显著的性能提升。

Karpathy的观点

AI领域知名专家Karpathy对此技术给予高度评价,认为投机采样是一种优秀的推理时间优化方法。他的观点进一步增强了该技术的可信度和重要性。

研究背景与理论支持

Karpathy基于多项研究(包括谷歌大脑、UC伯克利、DeepMind的研究成果)阐述了投机采样的理论基础。研究发现,在处理单个token和多个token时,所需时间并无显著差异,这一现象为投机采样的有效性提供了支持。

- 内存限制:推理过程中的采样速度受限于内存,投机采样通过将多个token同时处理,能够更有效地利用内存资源。

- 草稿模型的作用:利用小模型生成的草稿序列,能够在多数情况下快速通过大模型的校验,从而提高整体处理效率。

投机采样的实际应用

通过实际测试,Georgi Gerganov展示了投机采样在不同模型中的速度表现,证实了该技术在实际应用中的有效性。具体数据如下:

- F16 34B模型:推理速度约为10 token/s

- Q4 7B模型:推理速度约为80 token/s

- 使用投机采样后的34B模型:速度提升至20 token/s

未来展望

- 技术普及:随着技术的发展,340亿参数的模型可以在个人计算机上运行,这意味着AI技术的门槛正在降低。

- 系统协同:现代大型语言模型(LLM)并非依靠单一突破,而是多个组件的有效协同工作。投机解码作为一个成功的示例,展示了系统思维在AI领域的重要性。

结论

投机采样技术为大型语言模型的推理过程提供了新的思路和方法,不仅提升了速度,也确保了生成内容的质量。随着技术的不断进步,未来将有更多的应用场景受益于这一创新,推动AI技术的进一步发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...