耶鲁大学联合剑桥大学及达特茅斯学院的研究团队,推出了一款名为 MindLLM 的人工智能工具,专为医疗行业设计。该工具具备将脑部功能性磁共振成像(fMRI)数据转化为文本的能力,在多个基准测试中,其表现超越了业内现有技术,如 UMBRAE、BrainChat 和 UniBrain。

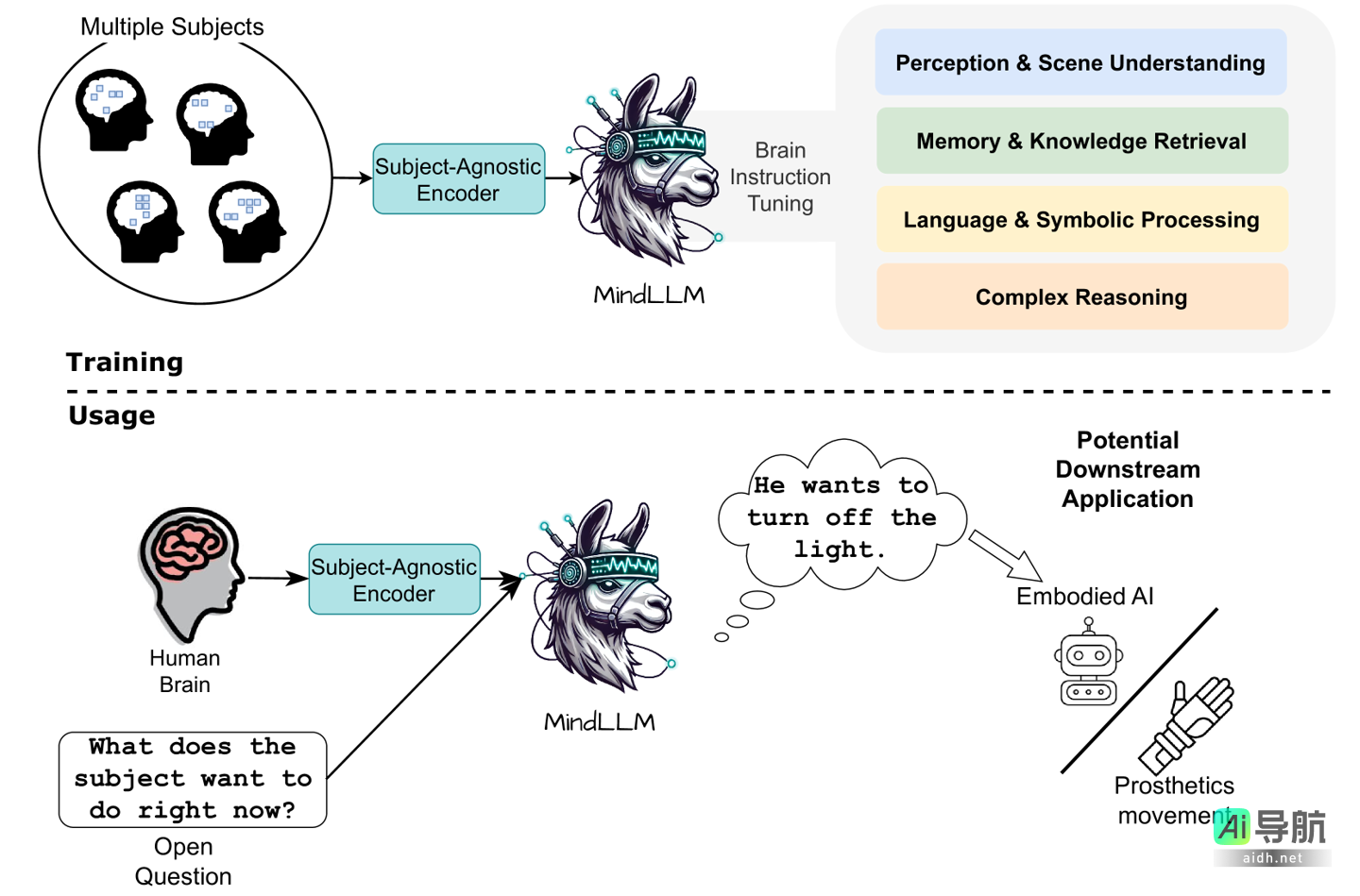

MindLLM 的构成包括 fMRI 编码器与大型语言模型,能够解析 fMRI 扫描中的立体像素(Voxels),从而解读脑部活动。其 fMRI 编码器利用神经科学中的注意力机制,能够适应不同输入信号的结构,以便实现多样的分析任务。

研究团队还为该工具引入了脑部指令调优(BIT)的方法,显著提升了模型从 fMRI 信号中提取多种语义信息的能力,使其能够执行如图像描述、问答推理等多项解码任务。

测试结果显示,在文字解码、跨个体泛化以及新任务适应性等基准测试中,MindLLM 相较于行业模型分别提高了 12.0%、16.4% 和 25.0%。这一成果表明,MindLLM 在适应新受试者与处理未知语言推理方面的表现优于传统模型。

然而,研究人员指出,目前该模型仅能分析静态图像信号。若未来对其进行进一步优化,MindLLM 有望演变为实时 fMRI 解码器,广泛运用于神经控制、脑机接口及认知神经科学等领域,可能在神经假肢的感知能力修复、精神状态监控及脑机交互等应用方面产生积极影响。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...