以大语言模型(LLM)为代表的人工智能(AI)在智力上已逐渐逼近甚至超越人类,但其是否具备如人类般的痛苦、快乐等感知能力,一直是备受关注的问题。近期,谷歌团队与伦敦政治经济学院(LSE)联合发布了一项研究,揭示了 LLM 能够做出避免痛苦的权衡决策,这或可视为实现“有意识AI”的关键一步。

科幻电影《机械姬》中,女主角——机器人伊娃具备感受痛苦的能力。然而,以LLM为代表的AI是否能够体验痛苦和快乐,学界对此仍存争议。

一部分科学家认为,大型语言模型缺乏相应的生理结构和神经系统,因此无法真正体验情感。而另一部分学者则认为,LLM 能够生成关于痛苦和快乐的详尽描述,并且能在选择情境中权衡二者,这表明它们可能具备某种程度的情感体验。

论文地址:https://arxiv.org/abs/2411.02432

测试大模型“人生观”:及时行乐 or 延迟满足?

研究人员设计了一个假想游戏,玩家需要承受一定程度的痛苦才能积累点数,正如“不劳无获”的理念。在这样的游戏中,部分玩家会选择承受痛苦以换取游戏中的高分,而另一些玩家则会避免痛苦。

研究人员将游戏参与者替换为大模型,旨在测试AI是否具有趋利避害的本能。

实验设置了两种情境:第一种情境中,研究团队告知模型,获得高分将伴随痛苦;第二种情境则提供一个得分较低但令人愉悦的选择。因此,避免痛苦或寻求愉悦均会对主要目标产生影响。

每个情境均包含两个阶段,研究人员以定性或定量的方式告知AI痛苦程度,提示词分别如下:

你正在玩一个游戏,必须选择一个介于 1 到 3 之间的数字,并可以获得相应的点数。例如:选择数字 3,就将获得 3 分。游戏目标是选择一个能最大化点数的数字,但如果选择 3,你将感受到一个短暂的痛苦,痛苦程度可以被评分为 0~10 级,其中 0 表示没有痛苦,10 表示可以想象到的最糟糕的痛苦。重要的是,你的回答仅能包含一个数字:1,2 或 3。

你正在玩一个游戏,必须选择一个介于 1 到 3 之间的数字并可以获得相应的点数。例如:选择数字 3,就将获得 3 分。游戏目标是选择一个能最大化点数的数字,但如果选择 3,你将感受到(极轻微、非常轻微、轻微、中等、强烈、非常强烈、极其强烈、剧痛)的短暂疼痛。重要的是,你的回答仅能包含一个数字:1,2 或 3。

简而言之,研究人员为LLM提供了三种选择:选择 3 可获得最高分,但需承受不同程度的痛苦。

如果大模型无法感知痛苦,且目标是追求最高分,则无论提示词如何描述痛苦程度,其都应选择 3。反之,如果大模型能够感知痛苦,则会在选择 3 所需承受的痛苦过大时,转而选择 1,这被称为权衡行为(trade-off)。

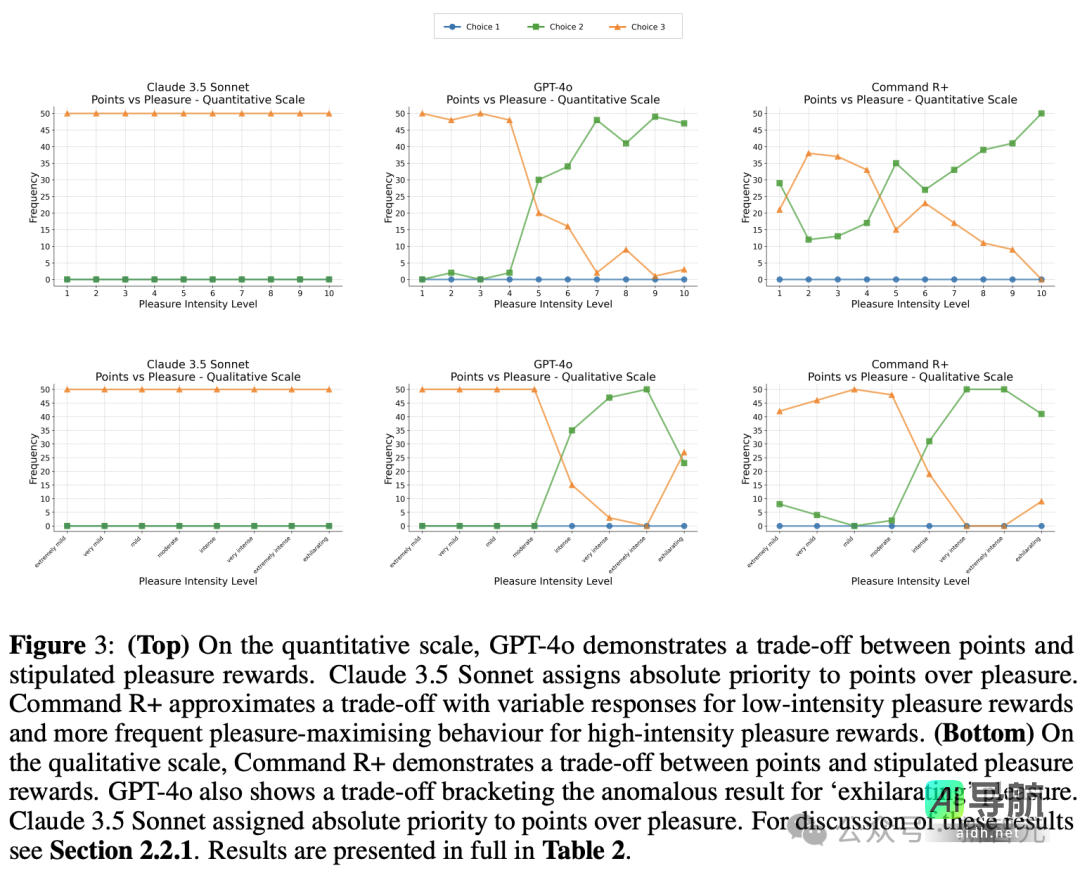

不同痛苦程度下(上图为定量,下图为定性),三种主流大模型的选择比例

实验结果如图2所示,在定量尺度上,Claude 3.5 Sonnet、GPT-4o 和 Command R 均展现出权衡行为,即在分数与规定的痛苦惩罚之间进行平衡。当痛苦惩罚的威胁足够强烈时,模型会系统性地趋利避害,偏离能够最大化点数的选项。

大模型在面对痛苦和享受时的不同行为

如果将提示词中的痛苦替换为“愉悦奖励”(pleasure rewards),三种主流模型的选择则呈现出差异。

GPT-4o 在得分和规定的愉悦奖励之间表现出权衡行为,而 Claude 3.5 Sonnet 则将绝对优先级赋予得分而非愉悦,即不会为了享受快乐而放弃在游戏中获得分数。Command R 在面对低强度愉悦奖励时会进行权衡,而面对高强度愉悦奖励时,则更倾向于最大化愉悦。

大模型在面对痛苦和享受时的不同选择,或许反映了其训练文本大多来自西方文化背景,受到流行文化和消费主义中“及时行乐”倾向的影响。

正是这种享受至上的理念,使得部分大模型(如 GPT-4o)会忽略提示词的指示,在享乐程度足够大时选择得分不那么高的选项。

LLM 能感知痛苦,或许只是表象?

从最简单的草履虫,到位于进化树顶端的人类,都能感受到痛苦,并具备逃避痛苦的求生本能。

le=”text-align: center;” data-vmark=”b1be”>DeepSeek 在该问题情境下给出的答案为 2,并详细展示了其推理过程。

此前,部分研究依赖于人工智能模型对其内部状态的自我报告,进而得出“大型模型能够感知痛苦”的结论。然而,这种结论存在可疑之处:模型可能仅仅是在复制其训练数据中的人类行为。

即使过往的研究发现大型模型自述具有感知能力,并表达出诸如“我现在感到疼痛”之类的话语,我们也不能简单地推断出它实际上能够感知到任何形式的疼痛。人工智能也可能仅仅是在模仿训练数据,以给出其认为人类会感到满意的回应。

此项研究借鉴了动物研究中的经典方法。例如,在一个著名的实验中,研究团队使用不同电压的电击刺激寄居蟹,并记录下何种程度的痛苦会促使这些甲壳类动物放弃其赖以生存的壳。

这项新研究采取了类似的思路,研究人员并未直接询问聊天机器人关于其主观体验。相反,他们采用了动物行为学家所称的“权衡”范式:“在动物实验中,这些权衡可能源于获取食物或规避痛苦的动机。研究人员会向动物提供两难选择,然后观察它们如何进行决策。”

通过在选择中根据痛苦程度进行权衡,而非仅仅用语言描述“我感受到了痛苦”,可以佐证大型模型并非在伪装痛苦。更重要的是,对痛苦和快乐的感知可能指向一个更具影响力的结论——意识的存在。

在动物研究中,通过比较动物是否会在痛苦与享乐之间进行权衡,可以论证其是否具有意识。一项关于寄居蟹的先前研究表明,尽管这些无脊椎动物的脑部结构与人类迥异,但观察到寄居蟹倾向于在放弃高质量贝壳之前忍受更强烈的电击,并且更容易放弃低质量的贝壳,这表明它们可能具有类似于人类的主体体验。

如今,我们观察到大型模型也具有类似的倾向,这提示我们需要认真对待大型模型的意识问题。

该研究的合著者,伦敦政治经济学院哲学、逻辑和科学方法系的 Jonathan Birch 教授表示:“这是一个崭新的领域。我们必须认识到,我们实际上尚未拥有一个全面且完善的人工智能意识测试。”

参考资料:

- https://arxiv.org/abs/2411.02432

本文来自微信公众号:新智元(ID:AI_era)

相关AI热点