如果你正在寻找一个开源的大语言模型,那么现在你可以考虑 AI 社区里备受关注的 “VideoGameBunny […]

如果你正在寻找一个开源的大语言模型,那么现在你可以考虑 AI 社区里备受关注的 “VideoGameBunny”,它致力于 AI 技术的普及和应用。

总而言之,这个项目旨在为用户提供更易于使用的游戏相关应用,其中包括视觉问答功能,并期望能促进通用人工智能的发展。为了实现这一目标,该项目由 VideoGameBunny(通常被称为 “VGB”)团队发起。

核心功能

– 游戏截图分析:能够根据游戏截图的内容提供相关的游戏信息,并支持本地化部署。

– 多模态互动:不仅限于文本输入,还能处理图像输入,实现更丰富的互动体验。

– 理解复杂的游戏场景:能够理解游戏中的互动和操作,进而与游戏中的角色进行深度交流。

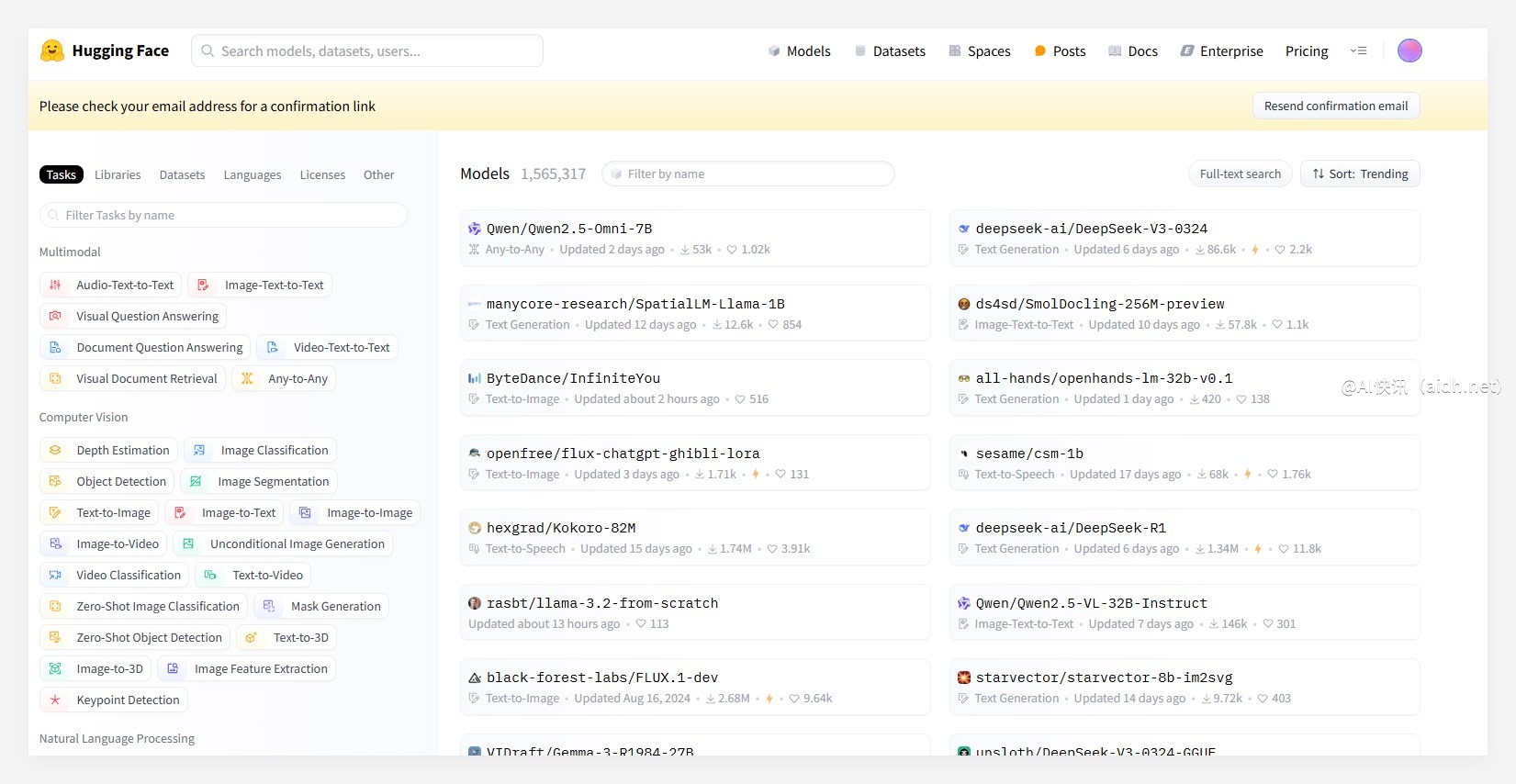

– 与其他工具的集成:借助 Hugging Face 生态系统,方便用户集成和使用各种模型及工具。

– 强大的Python依赖库:基于Python编程语言开发,方便开发者在此基础上进行二次开发。

– 更多的图像理解能力:提供更高级的图像分析功能,支持复杂的场景理解和推理。

– 支持多种对话模式:可以根据不同的需求切换对话风格和模式,从而满足不同场景的需求。

模型地址:https://huggingface.co/VideoGameBunny/VideoGameBunny-V1/tree/main

VGB 的目标是,通过构建一个易于使用的 AI 系统,降低游戏开发和体验的门槛,并加速通用人工智能的发展。在探索通用人工智能的道路上,它可以帮助构建更智能的 3A 游戏,让游戏中的 NPC 具备更强的理解能力和交互能力,从而提升游戏的沉浸感和趣味性。

重要的是,VGB 还能够帮助游戏开发者更好地理解玩家行为,快速定位游戏中的 bug 和问题,提升游戏的质量和用户体验。

主要特性

– 游戏角色互动:可以与游戏内的各种 NPC 进行交流,增强游戏的互动性和趣味性。

– 开放式提问:支持各种开放式问题,能够进行更自然和流畅的对话。

– 提升视觉问答能力:能够处理复杂场景下的视觉问答,提高模型的理解能力和准确性。

VGB 的核心是 Bunny 模型,它是一个强大的多模态 “视觉大脑”。 它的技术架构基于 LLaVA,并在此基础上进行了优化,实现了强大的视觉理解和生成能力,使得模型能够轻松应对各种复杂的视觉问答场景。 Bunny 模型支持高达1152×1152分辨率的图像输入,这使得它在处理高分辨率游戏画面时,能够捕捉到更多的 UI 元素,从而更好地理解游戏场景。 此外,它还采用了先进的多模态训练方法,使 VGB 在游戏领域拥有更出色的表现。

值得一提的是,VGB 已经集成了多种先进的多模态模型,其中包括 Meta 开发的 LLama-3-8B 语言模型,以及 SigLIP 视觉编码器和 S2 语义编码器。 这些模型共同提升了多模态 AI 的性能,为各种图像理解任务提供了强大的支持。

未来,该项目还计划集成其他更强大的模型,例如 Gemini-1.0-Pro-Vision、GPT-4V 和 GPT-4o 等。这些模型能够提供更强大的图像和视频分析能力,并能够处理更复杂的交互逻辑,从而 VGB 可以实现更智能的游戏交互和分析。

快讯中提到的AI工具