本文由微软亚洲研究院的谢天、洪毓谦、邱凯、武智融、罗翀,九坤投资的高梓添、Bryan Dai、Joey Zhou,以及独立研究员任庆楠、罗浩铭共同撰写。

通过单一逻辑益智题训练,AI数学竞赛的表现竟显著提升?

在中国的深度学习团队成功突破硅谷的技术封锁后,它们再度推出重磅研究,揭示了DeepSeek R1模型背后的重要原理。该团队利用仅五千条合成数据进行低成本的强化学习,使得7B的小型模型在逻辑推理评测中超越了OpenAI的o1,甚至与o3-mini-high的表现相媲美。更为惊人的是,在完全未曾接触过的美国数学奥林匹克(AIME)测试中,模型的推理能力提升了125%。

- 论文标题:Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning

- 论文链接:[arXiv:2502.14768](https://arxiv.org/abs/2502.14768)

- Github链接:[GitHub](https://github.com/Unakar/Logic-RL)

这是首个深入探讨类R1强化学习模型的训练动态过程的研究,值得强调的是,该团队不仅开源了完整的代码,还提供了详细的参数设置、训练数据和设计经验。

研究团队明确提出要解决以下问题:

1. DeepSeek R1所采用的GRPO算法是否为最优的强化学习(RL)算法?如何配合参数调优实现稳定的训练?课程学习是否仍具有效性?2. 从基础模型引入RL与完全冷启动相比,两者之间存在哪些显著差异?哪种方法更加优越?3. 在训练阶段,模型输出长度通常呈现近似线性增长的扩展法则,但这种增长是否等同于推理能力的提升?4. 当模型频繁使用“verify”、“check”等反思性词汇时,是否意味着推理能力得到增强?哪些标记(token)能可靠地反映推理性能的提升?5. RL学习是否真正掌握了抽象推理能力,还是依赖问题模板的机械记忆?相较于传统的有监督微调(SFT)的方法,它的优势究竟体现在哪里?6. 在推理过程中,模型经常混合使用中文和英文,这种语言切换现象如何影响性能提升?是否存在潜在的负面影响? 强化学习(RL)训练过程中的各项指标变化情况。红线代表模型回答长度,蓝线显示验证集的准确率,黄色散点则为两种不同领域(OOD)数学竞赛的正确率,三者均展现出稳定增长的趋势:

强化学习(RL)训练过程中的各项指标变化情况。红线代表模型回答长度,蓝线显示验证集的准确率,黄色散点则为两种不同领域(OOD)数学竞赛的正确率,三者均展现出稳定增长的趋势:

在测试中所需的计算负载自然而然地从数百个标记扩展至数千个,暗示RL训练正在鼓励模型不断探索和修正其思考路径。

通过5000个逻辑问题的训练后,该7B模型获得了一系列原本在逻辑语料库中不存在的高级推理技能,包括自我反思、验证和总结能力。在未曾见过的数学竞赛题(AIME/AMC)上的表现分别提高了125%和38%。

方法

数据设定

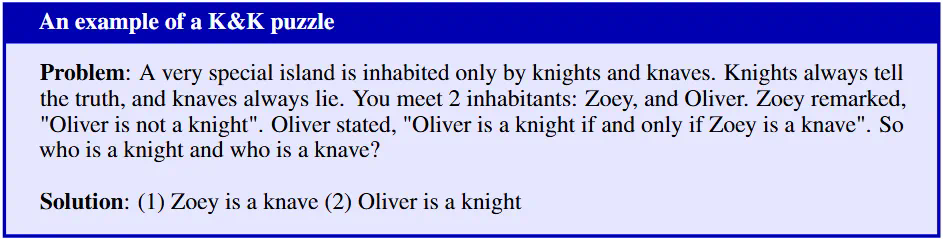

由于常见的数学训练集在问题难度上缺乏明确界限,数学问题往往具有不确定的逻辑深度及知识背景要求,这对可控的分析实验十分不利。因此,为了探究推理模型的机制,作者转向完全由程序合成的“逻辑谜题”作为训练数据。

示例问题:在一个特殊的岛屿上,只住着骑士与骗子。骑士总是真话,而骗子总是说谎。你遇到了两位岛民:Zoey和Oliver。Zoey说:“Oliver不是骑士。”而Oliver则说:“Oliver是骑士,且Zoey是骗子。”请问,谁是骑士,谁是骗子?

此“骑士与骗子”的谜题,由于其合成设计及逻辑严谨性,非常适合进行深入分析:

1. 该谜题对模型而言为全新数据,非常适合用作泛化能力的评估。2. 通过调整参与人数(从2到8个)以及逻辑运算的深度(1到4种布尔运算符的组合),可以灵活调节问题的难度。3. 每道谜题均具备唯一明确的正确答案,答案的正确性由生成算法进行保障。解答过程中需要进行严格的演绎推理,从而降低了奖励作弊的风险。4. 这一设计消除了自然语言任务中常见的模糊性,使我们能够清晰地分辨真正的推理能力与数据表面上的记忆能力。

奖励设计

在早期阶段,模型会试图以作弊的方式来获取奖励:

- 直接跳过 的思考过程,直接给出答案。

过程”,以逃避实质性的推理。

经过多轮迭代改进奖励函数,研究者设计了一种几乎无法被操纵的基于规则的奖励系统。该系统仅包含两种奖励类型:格式奖励和答案奖励。思考标签必须严格依次出现,并且每个标签只出现一次;思考过程应包含有效推理,答案的呈现应具备可提取性和可读性。

- 格式奖励:依据格式的正确性给予 +1 或 -1 的奖励。

- 答案奖励:若答案无法提取,则奖励为 -2;若答案存在部分错误,奖励为 -1.5;若答案正确,则奖励为 +2。

为降低基础模型指令遵循的难度(遵循先思考再回答的规则),研究者建议直接在提示语中手动插入 标签。

实验结果

通过对百组实验进行比较,研究者评估了 PPO、GRPO 及 REINFORCE++ 算法。最终,他们选择了性价比最高的 REINFORCE++ 算法以完成主要实验。团队按照 DeepSeek Math 论文的建议,对 REINFORCE++ 实现进行了调整,提出了两项修正:将 KL 惩罚从奖励计算中移除,转入损失函数中;同时更换 KL 估算器,采用了一种无偏非负的 KL 估算方法。

在训练方法上,研究者尝试了多种复杂调度(如高低温多阶段训练),发现效果提升有限,因此决定采用最简单的训练方式:以 4e-7 的学习率和 0.7 的温度进行持续训练。经过 3.6K 步的训练,模型在表现上超越 OpenAI 的 o1,达到了 o3-mini-high 性能水平的两倍。 有趣的发现与分析

有趣的发现与分析

「思考」token 词频与推理能力的关联性 研究者分析了与思考相关的词汇在模型输出的 标签内出现与否对答案准确率的影响:

研究者分析了与思考相关的词汇在模型输出的 标签内出现与否对答案准确率的影响:

1. 当出现 “wait”、”verify”、”yet” 等词时,推理性能显著提高。然而,意外现象是“recheck”的出现反而导致推理得分下降,这表明并非所有被认为是思考词的词汇都会提升模型性能。recheck 可能暗示模型存在犹豫,因此更容易犯错。2. 使用“re-evaluate”(再次评估)的行为与使用“reevaluate”截然不同。前者有助于提高推理效果,而后者则会降低推理得分。研究者调查了模型的原始输出,发现前者的出现频率较高,而后者几乎未被使用,这表明模型更倾向于使用自己偏好的词汇,从而更顺畅地进行推理。3. 语言混合现象(如中英混杂回答问题)虽有趣,却往往削弱模型性能,增加错误率。基于此,研究者建议在格式奖励中增加语言一致性惩罚,以提升用户的可读性,同时潜在地增强模型性能。

突如其来的顿悟时刻或许根本不存在 研究者对训练过程中与思考相关词汇的频率变化进行了统计。增强学习(RL)训练自然提升了与反思相关词汇(如 verify、check)及语气委婉词(如 let’s、yet、now that 等)的使用频率。

研究者对训练过程中与思考相关词汇的频率变化进行了统计。增强学习(RL)训练自然提升了与反思相关词汇(如 verify、check)及语气委婉词(如 let’s、yet、now that 等)的使用频率。

这些分析显示,所谓的顿悟时刻(Aha moment)并不存在。思考性词汇在训练的头十步中已略有出现,但频率非常低;随着训练进展,这些词汇的使用频率也仅缓慢上升,没有出现突发的显著增长。

SFT 对记忆的依赖;RL 表现出更好的泛化性

通过扰动训练数据集,例如调整逻辑题中的表述(将 “and” 改为 “or” 或 “not”),以及调换多方陈述的顺序,导致问题及其答案的解答路径完全变化。如果模型确实掌握了题目背后的推理技能,那么在题目经过扰动后,其答题的正确率应维持在相当水平。因此定义记忆分数(LiMem)为:测试集的正确率乘以训练集扰动后的错误率。

为了获得合理的有监督微调(SFT)思维链数据,研究者从原始模型进行 50 次拒绝采样,选择出正确且最短的输出作为新的思维链数据集(CoT)。基于此,对拒绝采样微调(RFT)和强化学习(RL)的效率与记忆能力进行了合理对比。 SFT 在记忆分数(横轴)大幅增长的代价下,仅换取了测试集分数的少量提升;而 RL 实现了几乎不增长的记忆性(甚至出现了负增长),但测试集分数在纵轴上却快速上升。

SFT 在记忆分数(横轴)大幅增长的代价下,仅换取了测试集分数的少量提升;而 RL 实现了几乎不增长的记忆性(甚至出现了负增长),但测试集分数在纵轴上却快速上升。

这一现象暗示了强化学习的优越性:其并不依赖于数据本身的结构,通过极低的数据成本即可实现高效的模型演化,展现出超越现有数据范畴的强大泛化能力。

更长的思考过程是否意味更优的推理性能?出的思维链条过长,从而更易引发长度崩坏的现象。最有效率的思考过程通常源自最短且正确的路径。

因此,更长的输出长度并不是评估推理性能的有效指标,而应视为训练过程中的一种自然副产品。对测试集成绩和模型输出的观察将是一种更为稳妥的做法。

其他结果

除了上述发现,该研究还揭示了几个有趣的结果:

- 冷启动虽然具有一定优势,但并非必需。无论是从基本模型还是指令模型开始,训练动态都呈现出惊人的相似性。然而,通过微调(SFT)后的模型通常会表现出略高的准确率。

- 难度递进的课程学习仍然具有重要性。在固定数据混合比例下,精心设计的课程学习方法总是优于随机扰动方式。

有关更多研究细节,请参见论文原文!

相关AI热点