Meta 近期发布了一项关于提升大型语言模型(LLM)性能的新技术,旨在降低在特定任务中对计算资源的需求。此项 […]

Meta 近期发布了一项关于提升大型语言模型(LLM)性能的新技术,旨在降低在特定任务中对计算资源的需求。此项技术并未直接改进模型架构,而是在硬件层面优化了相关算法。

该技术的核心在于减少运行模型所需的浮点运算次数,这一指标直接影响模型的推理速度。通过优化算法,可以在相同硬件条件下实现更高效的计算。

与以往的软件优化方法不同,此项技术专注于硬件加速,尤其是在图形处理器(GPU)上的优化更为显著。研究结果表明,该方法可以有效提升大型模型的计算效率。

在实践中,这项创新技术已应用于规模达 1280 亿参数的模型。结果显示,它能够在保证模型性能的同时,显著降低计算成本,提升运行效率。

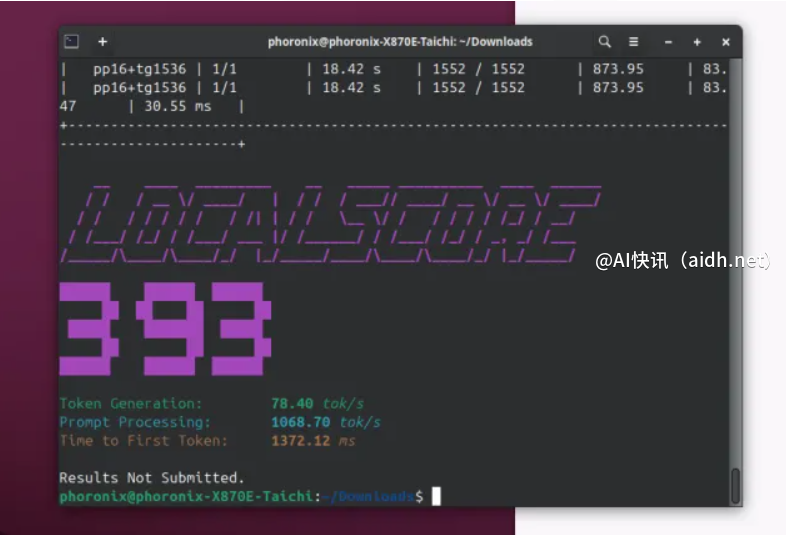

Meta 的解决方案是通过调整 Transformer 架构中的一种特定结构,即前馈网络(FFN),来实现上述优化。通过减少中间层神经元的数量(例如从 1.34 万降低到 80 亿),同时保持输入层神经元的数量(例如 1280 亿),可以在不损失性能的前提下降低计算复杂度。实验表明,模型性能降低不到100%,同时显著降低了计算成本。进一步的实验表明,这项技术能够将模型的推理速度提升约 4 倍。

为便于理解,以下列出该技术的一些关键优势:

更快的模型推理速度:通过减少计算量,该技术可以提升模型在实际应用中的响应速度,使用户能够更快地获得结果。

降低硬件需求:该技术减少了对 GPU 算力的依赖,这意味着可以在现有 GPU 资源上运行更大的模型,或者在相同的硬件上获得更高的性能。

优化的计算效率:该技术可以在保证模型性能的前提下,显著降低计算成本,从而提高整体效率。

降低内存占用和提升运行效率:Meta 利用 CUDA 优化了 EmbeddingBag 算子,从而提升了数据处理速度。此外,对 silu 激活函数进行了改进,优化了内存访问效率。

总结一下这项技术的关键特点:

提高模型推理速度:显著提升模型在实际应用中的计算效率,从而加快推理速度。

降低硬件需求:使用较少的硬件资源即可达到相同的性能水平,降低了部署成本。总的来说模型更加高效。

通过减少不必要的计算环节,优化模型的运行效率。减少模型规模的同时保持其性能,降低计算成本。

需要注意的是,某些模型结构和计算框架可能无法完全兼容此项优化技术。

为了验证这项技术的有效性,Meta 在多个基准测试中进行了评估,包括:

自然语言理解任务(NaturalQuestions,TriviaQA)

多跳推理问答(HotpotQA)

知识和推理任务(MMLU,HellaSwag,OBQA,PIQA)

代码生成任务(HumanEval,MBPP)

实验结果表明,该技术在多个任务中均能有效提升模型性能,尤其是在自然语言理解任务中,表现尤为突出。

Meta 的这项技术为 AI 领域的大型模型优化提供了一种新思路,它不依赖于复杂的模型结构调整,而是通过算法优化提升硬件效率。这项技术有望降低 AI 应用的门槛,推动 AI 技术在各行各业的广泛应用。我们期待未来能看到更多类似的创新,加速 AI 技术的发展,并使其更好地服务于人类。

总而言之,Meta 的模型加速方案提供了一种优化现有大型语言模型的手段,旨在提升性能并降低计算成本。

这项技术的重要意义在于,它能够帮助我们更经济高效地利用 AI 的强大能力,从而推动 AI 技术的普及和应用。

参考文献:https://arxiv.org/pdf/2412.09764

快讯中提到的AI工具

Figma设计转React应用的最简便方式