摘要:

最近有报道称,耶路撒冷希伯来大学的研究人员发现,在检索增强生成(RAG)系统中,尽管总文本长度不变,处理的文档 […]

最近有报道称,耶路撒冷希伯来大学的研究人员发现,在检索增强生成(RAG)系统中,尽管总文本长度不变,处理的文档数量对语言模型的性能有显著影响。

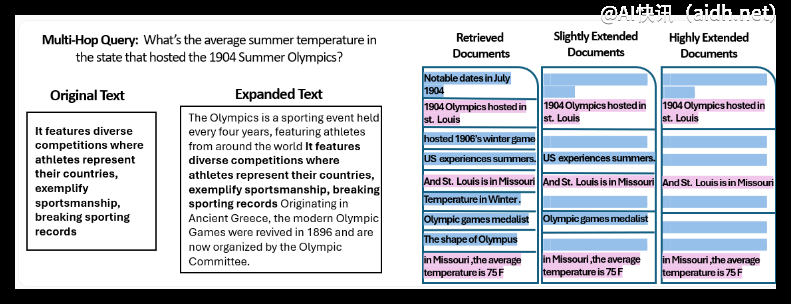

研究团队进行了一项实验,利用MuSiQue验证数据集中的2,417个问题,每个问题链接到20个维基百科段落。其中包含了2到4段相关答案信息,其余段落则作为干扰项。为了探究文档数量对模型性能的影响,团队创建了多个数据分区,逐步将文档数量从20个递减到仅保留2至4个包含相关信息的文档。为保持总标记数一致,研究人员使用原始维基百科文章的文本扩展了保留的文档。

实验结果显示,在大多数情况下,减少文档数量可使语言模型性能提升约10%。研究测试了多个开源模型,如Llama-3.1、Qwen2和Gemma2。Qwen2模型在文档数量变化时表现稳定,而Llama-3.1和Gemma-2的性能随着文档数量增加而下降。

当只提供含有支持性信息的文档时,所有模型的表现都明显提升,这表明RAG系统中常见的相似但不相关的文档可能导致模型混淆并降低性能。有趣的是,在处理明显不相关的随机文档时,模型的表现反而更好,表明它们更容易识别和过滤与问题无关的内容。

研究人员强调,在设计检索系统时需要权衡相关性和多样性,以减少信息冲突。他们也承认研究存在一些局限性,例如缺乏对提示变化和数据顺序影响的分析。为促进该领域的进一步研究,该团队已公开数据集。

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/bnf08o7m

暂无评论...