Luma AI 开源 IMM:以推理效率为导向的图像模型预训练技术,实现图像生成速度十倍提升 近年来,尽管深度 […]

Luma AI 开源 IMM:以推理效率为导向的图像模型预训练技术,实现图像生成速度十倍提升

近年来,尽管深度学习模型的数据量持续增长,但生成式预训练模型的生成速度却未能显著提升,成为AI领域一个瓶颈问题。Luma AI 针对这一难题,开源了名为 Inductive Moment Matching (IMM) 的图像模型预训练技术,该技术从推理效率角度出发,重新设计了预训练算法,实现了图像生成速度的显著提升,同时保持了甚至超越了现有模型的生成质量。

突破生成式模型效率瓶颈

Luma AI 认为,现有生成式预训练模型的效率瓶颈并非数据不足,而是算法未能充分挖掘数据的潜力。传统的模型训练方法如同“用锄头挖金矿”,效率低下。因此,Luma AI 致力于提升推理阶段的计算效率,而非单纯增加模型容量。IMM 技术正是这一理念的产物。

IMM 技术的核心创新:推理效率优先的设计理念

与传统的扩散模型逐步迭代的生成方式不同,IMM 在预训练算法设计中,将推理效率作为首要目标。它通过在推理过程中同时考虑当前时间步和目标时间步,实现了类似“瞬间移动”的效果,显著减少了所需的采样步骤。 这种“跳跃式”的生成方式,使得每次迭代都更具表达能力,并摆脱了线性插值的限制。

此外,IMM 结合了最大平均差异 (maximum mean discrepancy, MMD) 技术,为这种“跳跃式”生成提供了精准的导航,确保模型能够高效地生成高质量图像。

显著的性能提升与稳定性

实验结果表明,IMM 技术在多个数据集上取得了显著的性能提升:

- ImageNet256x256 数据集: IMM 使用比扩散模型和 Flow Matching 模型少 30 倍的采样步骤,就达到了 1.99 的 FID 分数,优于扩散模型 (2.27 FID) 和 Flow Matching (2.15 FID)。

- CIFAR-10 数据集: IMM 仅用 2 步采样就达到了 1.98 的 FID 分数,达到该数据集的最佳水平。

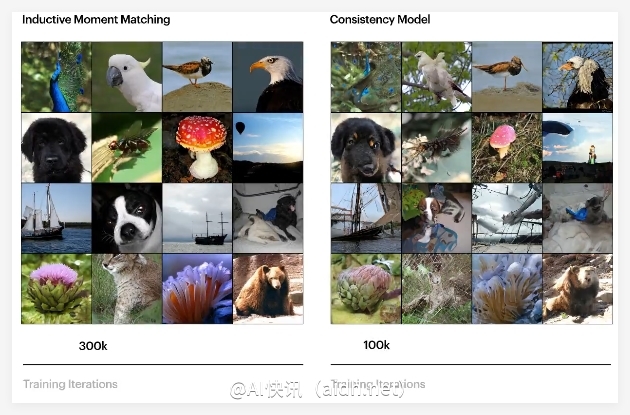

除了速度优势,IMM 还展现出优异的训练稳定性,无需特殊的超参数设计,即可在各种模型架构下稳定训练,这与训练容易不稳定的 Consistency Models 形成鲜明对比。

值得强调的是,IMM 并未使用扩散模型常用的去噪分数匹配或基于分数的随机微分方程。Luma AI 认为,IMM 的突破在于其以推理为先的设计理念,这使得他们能够识别并克服现有预训练范式的局限性。

展望未来:迈向多模态基础模型的新范式

Luma AI 相信 IMM 技术只是一个开端,它预示着迈向超越现有界限的多模态基础模型的新范式,并有潜力彻底释放创造性智能的潜力。

GitHub 仓库: https://github.com/lumalabs/imm