近年来,主要的变压器模型在大型语言模型(LLMs)方面取得了显著成果,包括 Gemini-Pro1.5、Cla […]

近年来,主要的变压器模型在大型语言模型(LLMs)方面取得了显著成果,包括 Gemini-Pro1.5、Claude-3、GPT-4 和 Llama-3.1,这些模型在处理基本的 token 上表现出色。

相较于以往,现在技术的发展使得这些先进的模型不仅能够生成复杂的文本,还能更高效地处理不同种类的信息,他们的多样性和灵活性让人耳目一新。如今的关键性技术,如调优策略,逐渐成为推动这些模型进步的核心所在,优化这些模型所需的计算资源也得到了改善,使得他们在面对各类任务时展现出更好的性能。

关于活跃的模型系统,这些转变已经展现出了显著的成果,使其在处理和生成各类文本方面都表现出色,并且有助于提升整体计算效率,这得益于诸如 FlashAttention 这样的新型注意力机制的应用。这些模型在处理信息时,不仅能提高准确率,也能缩短反应时间,使得它们能够更好地满足用户需求。

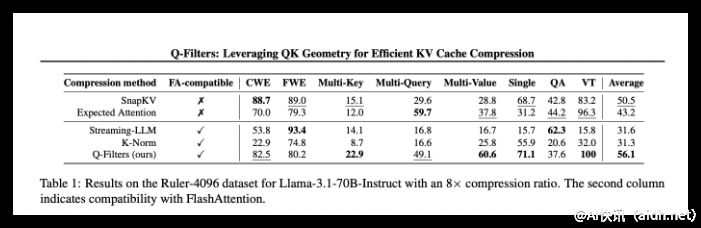

在数据处理技术的这股热潮中,各种优质的工具和技术逐渐涌现,包括 Miniml.AI 及其提供的 Q-Filters,这些工具能有效增强模型的响应能力和输出质量,而针对 KV 优化的细致调整使得模型更适合特定任务,从而发挥出更大的潜力,确保其生成的内容不仅丰富而且高效。

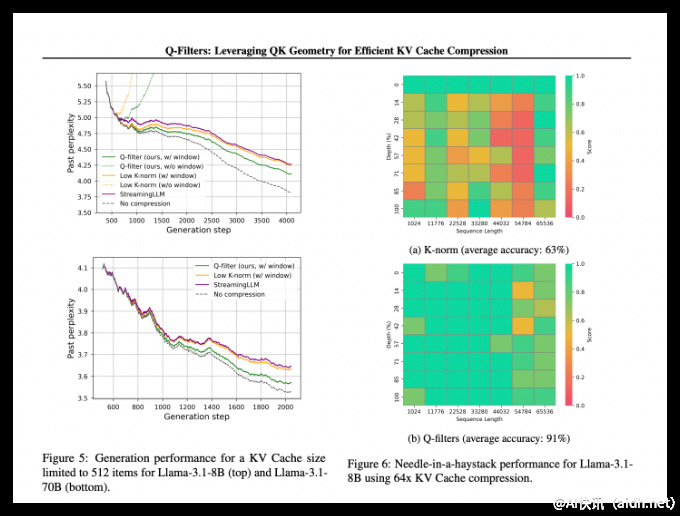

Q-Filters 的引入,标志着一场重要的技术革命,能够为模型提供更加精准的信息处理能力,以及更高的响应速度,这种强大的工具使得我们能够继续推动技术的前进,并激励进一步的创新和探索。这一技术的核心在于与 Llama-3.1-70B 模型的结合,确保了生成的内容在准确性和流畅度上达到新的高度。

“针对特定任务的 Q-Filters” 的引用,意味着这些工具的使用实际上能够提升 91% 的少量样本准确率,从而确保模型在生成的内容上都有良好的表现。虽然这项技术在处理1K至64K token 的时效性上表现优越,但后期仍需面对更复杂的挑战以不断提升模型性能。

参考链接: https://arxiv.org/abs/2503.02812

huggingface: https://huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

亲爱的读者:

🔍 Q-Filters 是当前为数不多能够优化 KV 处理效果的工具之一,帮助用户更好地利用大型语言模型的强大能力。

💬 我们期待未来技术的创新带来更高效的文本生成解决方案,让复杂的任务变得更加简单。

🚀 Q-Filters 已经在处理情境下取得良好效果,未来将与优秀的模型并肩前行,推动更好的应用场景。“可以期待,未来将提供多元化的信息处理选择。”

快讯中提到的AI工具