摘要:

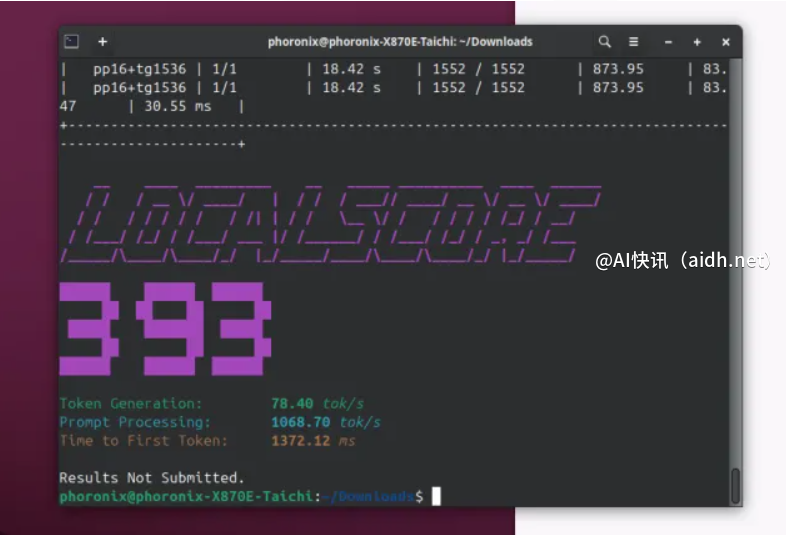

FlashAttention 通过改进的 Flash-Decoding 算法加速了大型 Transformer […]

FlashAttention 通过改进的 Flash-Decoding 算法加速了大型 Transformer 模型在自然语言处理中的解码过程,尤其是在处理大规模 LLM 时。其创新设计使得 Flash-Decoding 能够显著减少8倍以上的计算开销,同时保证了更高的解码精度和效率,尤其对于超大规模的文本生成任务,能提供更具挑战性的性能表现。这一突破性的进展在提升效率的同时,也为 AI 技术的前沿领域注入了强大动力,推动了现代语言模型的发展。

快讯中提到的AI工具

Deco

设计稿一键生成多端代码

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/2naa5396

暂无评论...