最近,NVIDIA 发布了一款新型视觉语言模型,名为 NVILA。据称,它在性能和效率方面都得到了显著提升,有 […]

最近,NVIDIA 发布了一款新型视觉语言模型,名为 NVILA。据称,它在性能和效率方面都得到了显著提升,有望推动 AI 应用的发展。

根据 NVIDIA 的说法,NVILA 在推理速度上比之前的版本提升了高达 4.5 倍,数据吞吐量也提升了 3.4 倍。此外,它在训练成本方面也有所降低,大约降低了 2 倍。据了解,这款模型是基于 LLaVa OneVision 架构构建的。

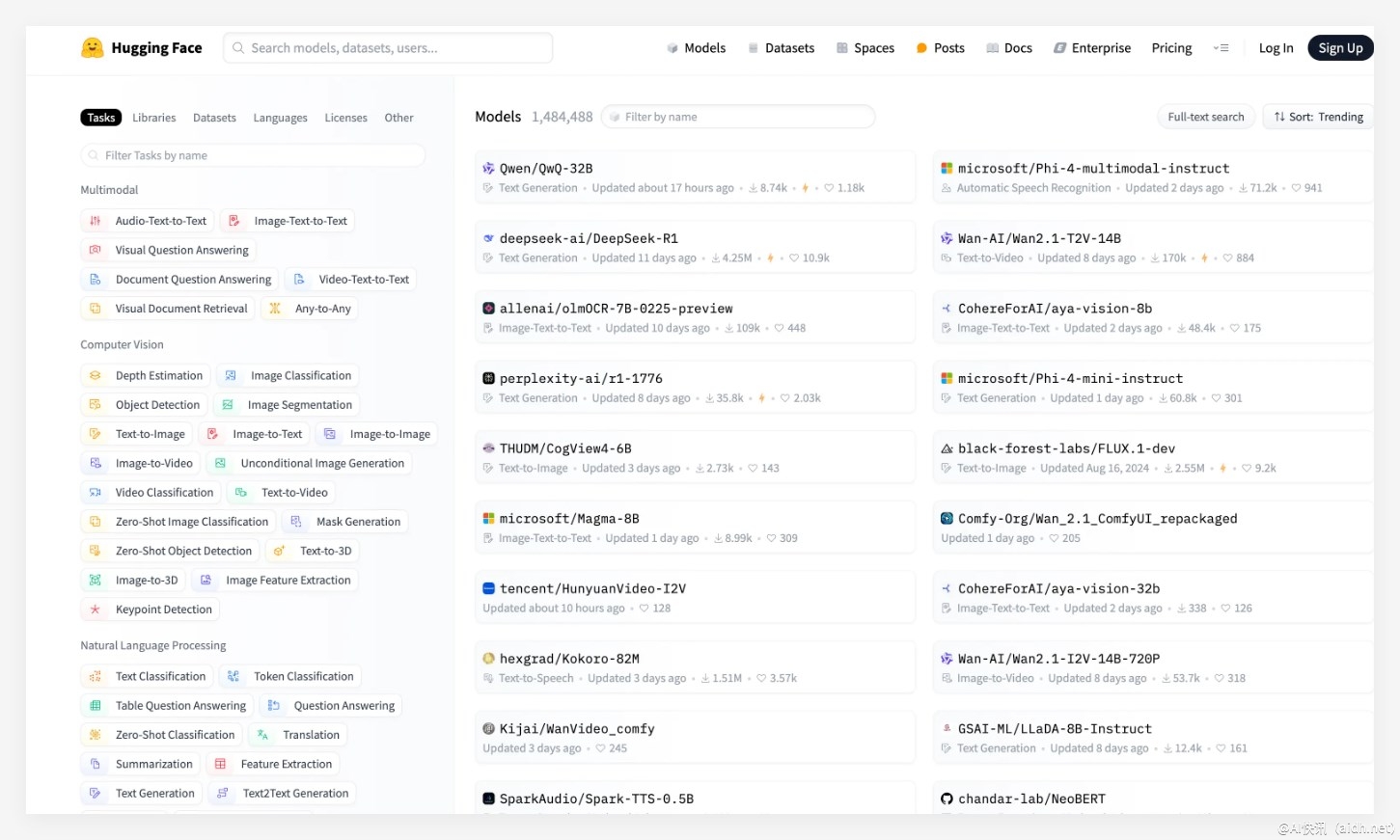

在模型兼容性方面,NVILA 能够无缝兼容 GPT4o Mini,并且能够与 GPT4o、Sonnet3.5 以及 Gemini1.5Pro 等其他大型语言模型进行集成。同时,NVILA 还支持 Llama3.2 的格式,方便开发者进行迁移。值得一提的是,NVIDIA 承诺,所有相关的模型权重都将发布在 Hugging Face 平台上,以方便研究人员使用,并促进模型的进一步发展。

NVIDIA 强调,使用该视觉语言模型的一个主要优势是其对计算资源的需求较低,只需要一个 7B 参数的模型就可以在 400 个 GPU 上运行。具体来说,7B 参数的模型只需要配备 64GB 显存的 GPU 即可。

此外,NVIDIA 还推出了一种名为“神经压缩”的技术,旨在优化视觉语言模型的性能。该技术通过减少模型推理过程中的计算量和内存占用,从而提高模型的效率。简而言之,该技术能够显著降低训练和部署的成本,同时保证模型的准确性。

具体而言,该模型使用了混合精度量化技术,可以有效地减少 token 的大小,从而降低显存占用,提高推理速度。NVIDIA 表示,该技术可以将每个视觉语言模型 token 的大小降低 2 倍。这意味着,用户可以在相同的硬件条件下运行更大规模的模型,或者在更小的硬件上运行现有模型。

为了进一步提升模型性能,NVILA 还集成了一系列先进的技术,包括 NVIDIA 自研的 VILA1.5 模型架构。此外,NVIDIA 还引入了一些优化技术,例如 S2 结构、DeltaLoss 量化方法以及 FP8 数据格式。

目前,一个包含 8B 参数的模型已经可以从 Arxiv 上获取。

论文链接:https://arxiv.org/pdf/2412.04468

要点总结:

✨ NVILA 模型在推理速度上提升了 4.5 倍,加速了 AI 应用的开发。

📌 通过优化计算和内存占用,NVILA 提高了模型的使用效率。

📍 NVIDIA 承诺将公开模型权重,以促进相关领域的研究和发展。

快讯中提到的AI工具

机器学习和人工智能技术的平台