摘要:

近期,OpenAI 在其官方网站上发布了一项新政策,要求未来某些人工智能模型必须进行组织身份验证后才能获得访问 […]

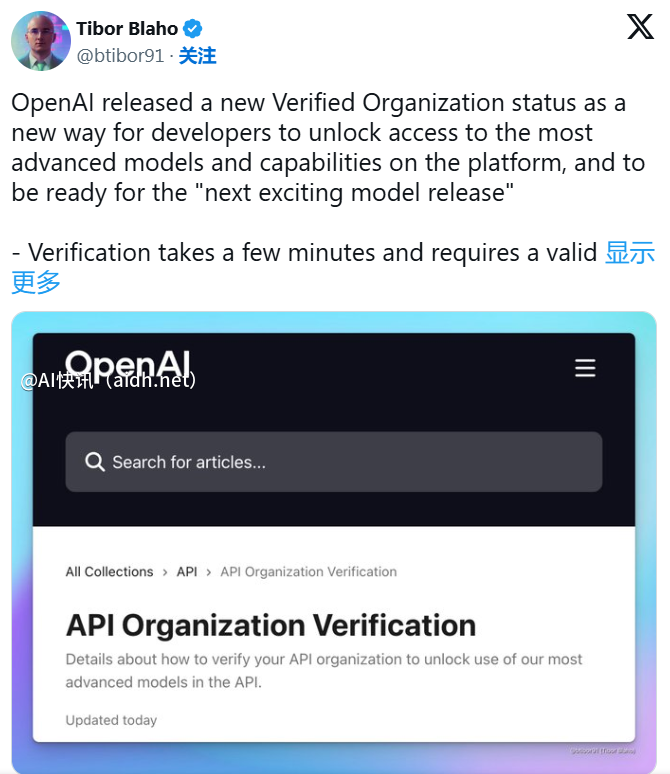

近期,OpenAI 在其官方网站上发布了一项新政策,要求未来某些人工智能模型必须进行组织身份验证后才能获得访问权限。这一名为“已验证组织”的验证流程旨在帮助开发者解锁 OpenAI 平台上的最新模型和功能,提高 AI 技术的安全性与可控性。

根据新政策规定,组织需要提供由 OpenAI API 支持的国家或地区政府颁发的身份证明文件进行验证。需要注意的是,每90天内,每个身份证明文件只能验证一个组织,并非所有组织都有资格进行此验证。OpenAI 在声明中表示:“我们致力于确保人工智能的广泛可及性和安全使用。” 同时公司也意识到,少数开发者可能会滥用其 API,违反使用政策。因此,引入身份验证程序旨在减少不安全的 AI 使用,继续向广大的开发者社区提供先进的技术。

随着 OpenAI 产品的复杂性和强大性的增长,这一新的验证流程被视为增强其产品安全性的必要举措。公司已发布多项报告,详细说明了其如何检测和减少模型的恶意使用,包括最近针对某些朝鲜团体的调查。同时,这一政策也可能旨在防止知识产权被侵犯。据报道,OpenAI 正在调查一个与中国人工智能实验室 DeepSeek 有关的组织,该组织可能在2024年底通过其 API 偷取了大量数据进行模型训练,显然违反了 OpenAI 的条款。值得一提的是,去年夏天,OpenAI 已经暂停了中国大陆以及香港、澳门用户对其服务的访问。

这一系列举措的推出标志着 OpenAI 在促进 AI 技术健康发展的同时,进一步加强了对其技术使用的监管,确保开发者在合法合规的前提下,能够更好地利用这些领先技术。

快讯中提到的AI工具

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/usrdmoke

暂无评论...