当前,AI模型正面临着一个严峻的挑战,即如何避免在训练过程中出现“模型崩溃”现象。这不仅仅是一个学术问题,更直 […]

当前,AI模型正面临着一个严峻的挑战,即如何避免在训练过程中出现“模型崩溃”现象。这不仅仅是一个学术问题,更直接关系到AI技术的进步和应用前景,我们需要对此高度关注。

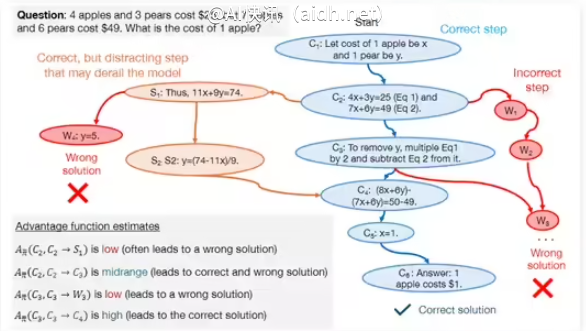

那么,什么是“模型崩溃”呢?简单来说,就是AI模型在反复地自我训练过程中,逐渐丧失了原有的学习能力。这就像学生过度依赖参考答案,最终导致思维僵化,无法独立思考一样,其根本原因在于训练数据的单一化和重复性。

这种现象的一个主要表现是,AI模型开始过度拟合某些特定的模式。一旦过度拟合,它就会将噪声视为规律,从而在泛化能力上大打折扣。举个例子,如果模型只接触过某种特定风格的“人像”图片,它可能就无法识别其他风格的“真实人像”了。更糟糕的是,这种“人像”概念可能会变得越来越扭曲,逐渐偏离真实情况。

为了更深入地了解模型崩溃,我们需要思考以下几个关键问题:

-

模型崩溃是不可避免的吗?是否存在一些方法可以减轻甚至避免这种现象的发生?

-

模型退化,是否意味着模型的性能一定会下降?

为了解答这些问题,我们需要深入研究模型训练的方式,包括数据集的选择和训练算法的设计。我们需要努力构建更加多样化和高质量的数据集,同时探索更加智能的训练方法,避免模型过度依赖于单一的模式。例如,可以尝试引入一定比例的“错误”数据(例如仅有1%),以此来提升模型的鲁棒性。总而言之,只有充分理解模型训练的内在机制,才能有效地避免模型崩溃现象的发生。

当然,模型崩溃问题也并非完全无法解决,通过引入一些创新性的训练方法,或许可以缓解这一问题。例如,可以采用更先进的数据增强技术,或者引入更有效的正则化方法,从而提高模型的泛化能力。只有不断探索新的训练策略,我们才能更好地应对模型崩溃带来的挑战。

那么,我们应该如何识别模型崩溃呢?

以下是一些可以用来判断模型是否发生崩溃的方法:

-

观察生成结果的多样性:如果生成的结果缺乏新意,总是重复相似的模式,这可能表明AI模型已经陷入了某种固定的套路。

-

监测生成结果的质量:如果生成的结果开始出现明显的错误或缺陷,并且这些错误无法通过训练得到纠正,那么可能表明模型已经开始退化。

-

评估模型泛化能力:通过使用不同的数据集进行测试,评估模型的泛化能力。如果模型在新的数据集上表现不佳,那么很可能出现了模型崩溃的问题。

模型崩溃是AI发展道路上必然会遇到的一个挑战,我们需要正视它。通过不断地改进模型训练方法以及监控模型的性能,我们可以最大限度地减少模型崩溃带来的负面影响,从而确保AI技术能够朝着更加健康和可持续的方向发展。只有这样,我们才能充分发挥AI的潜力,解决现实世界中的复杂问题。

参考链接:https://arxiv.org/pdf/2410.04840