这项研究引入了BGE-VL,一个用于多模态嵌入的大型基准测试集,它克服了现有基准测试的局限性。 BGE-VL数 […]

这项研究引入了BGE-VL,一个用于多模态嵌入的大型基准测试集,它克服了现有基准测试的局限性。

BGE-VL数据集包含丰富的多模态数据,能够更全面地评估模型的跨模态理解能力,其规模远超现有的基准,为模型评估提供了更可靠的依据。

与现有的基准相比,BGE-VL在数据规模和多样性方面显著提升,能够更有效地检测模型在不同模态下的性能差异,并识别模型的优势和不足。

BGE-VL 数据集的构建,旨在推动多模态模型在各个方面的性能提升,并为研究人员提供一个更完善的评估工具。

BGE-VL 在 MegaPairs 数据集的基础上进行了改进,MegaPairs 数据集包含了大量的图像-文本对。

通过与 MegaPairs 数据集的对比实验,研究者们验证了 BGE-VL 在评估多模态模型方面具有更高的精度和可靠性,为模型的改进提供了更清晰的方向。

改进后的 BGE-VL 不仅扩展了数据规模,还提升了数据质量,从而更准确地评估模型的泛化能力和鲁棒性,使其更适用于实际应用场景。

MegaPairs 数据集的优势在于其庞大的规模和多样性,这使得它成为一个理想的基准,用于训练和评估各种多模态模型。

MegaPairs 提供了对多模态模型进行全面评估的可能性,其丰富的图像文本数据可以有效地识别模型在不同模态下的性能差异。

MegaPairs 数据集的成功应用,推动了多模态研究的快速发展,为构建更强大的多模态模型提供了重要的基础。

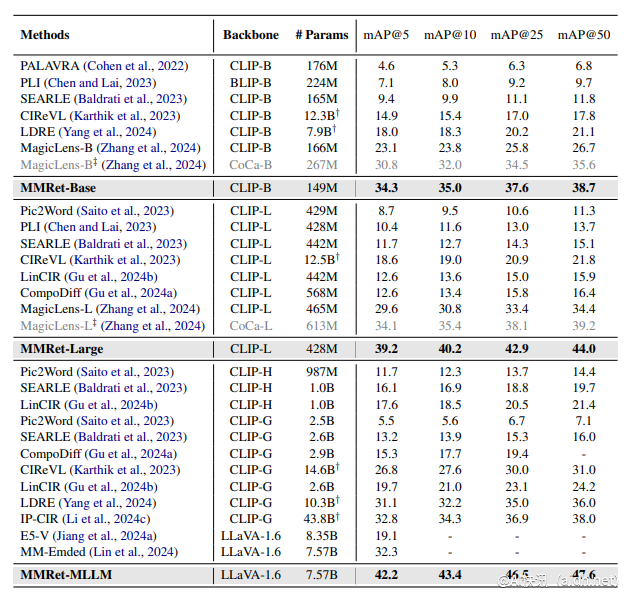

本研究对现有多模态基准进行了全面的改进,并提出了一个新的更全面且具有挑战性的基准,名为BGE-VL(Massive Multimodal Embedding Benchmark)。

BGE-VL 基准通过对现有基准的改进和扩展,提供了更全面的多模态理解评估,并为MegaPairs数据集的应用提供了有力的补充。

BGE-VL基准不仅扩展了数据规模,还提升了数据质量,并对不同类型的数据进行了更精细的划分,使评估结果更具说服力。

与其他基准相比,BGE-VL 提供了更具挑战性的任务,从而更有效地评估模型的跨模态能力,并促进模型的进一步改进。

此外,本研究还开源了BGE-VL,方便其他研究人员进行复现和进一步研究,推动多模态领域的共同进步。

总之,这项工作为多模态领域的研究提供了重要的资源,促进了更强大、更鲁棒的多模态模型的开发。

论文地址:https://arxiv.org/abs/2412.14475

代码地址:https://github.com/VectorSpaceLab/MegaPairs

模型地址:https://huggingface.co/BAAI/BGE-VL-MLLM-S1