摘要:

在最新的研究中,谷歌与卡内基梅隆大学及 MultiOn 团队共同探讨了合成数据对大型模型训练效果的影响。他们发 […]

在最新的研究中,谷歌与卡内基梅隆大学及 MultiOn 团队共同探讨了合成数据对大型模型训练效果的影响。他们发现,合成数据显著提升了大型模型在逻辑推理方面的表现,尤其是在解决数学问题时,提升幅度达到了八倍。这一发现对当前训练数据日益匮乏的情况具有重要意义。

目前,全球可获取的高质量文本训练数据约为300万亿条,但随着像 ChatGPT 这样的模型日益普及,对训练数据的需求急剧增加。预计到2026年,这些数据将难以满足需求。在这种情况下,合成数据成为一种至关重要的替代方案。

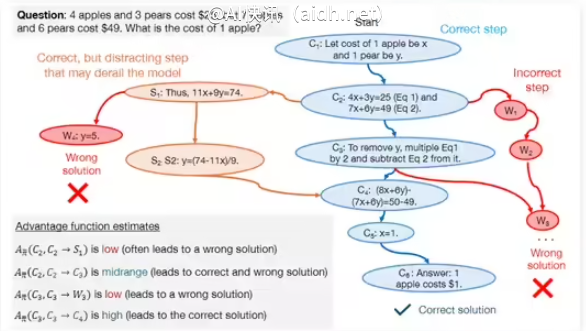

研究团队主要研究了两类合成数据,即正向数据和负向数据。正向数据是由高性能模型如GPT-4和Gemini1.5Pro生成的正确问题解决方案,为其他模型提供示范。然而,仅依赖正向数据进行训练存在一些缺陷,例如,模型可能只是通过模式匹配而非真正理解问题解决过程,导致泛化能力下降。

为了克服这些缺陷,研究团队引入了负向数据,即已验证为错误的问题解决步骤。这种数据有助于模型辨认常见错误,从而提高逻辑推理能力。尽管使用负向数据存在挑战,因错误步骤可能包含误导性信息,但研究人员通过直接偏好优化(DPO)方法,使模型能够有效地从错误中学习,明晰每个步骤在问题解决过程中的重要性。

在研究过程中,团队使用了DeepSeek-Math-7B和LLaMa2-7B等模型,在GSM8K和MATH数据集上进行了大量测试。结果显示,经过正向和负向合成数据预训练的大型模型在数学推理任务中的表现提升了八倍。这一研究成果不仅验证了合成数据在增强大型模型逻辑推理能力方面的巨大潜力,同时也为未来模型训练提供了新思路。

快讯中提到的AI工具

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/lvg46qhf

暂无评论...