Open-Sora 2.0:开源视频生成模型的里程碑 还在为高昂的视频生成模型成本望而却步吗?Open-Sor […]

Open-Sora 2.0:开源视频生成模型的里程碑

还在为高昂的视频生成模型成本望而却步吗?Open-Sora 2.0 的出现打破了这一现状。这款性能堪比商业级产品的110亿参数大模型,仅耗资20万美元(使用224张GPU)便训练成功,与动辄百万美元的闭源模型相比,性价比优势显著。其开源的模型权重、推理代码和训练流程,也为高质量视频创作打开了大门,使AI视频生成技术触手可及。

GitHub 开源仓库:https://github.com/hpcaitech/Open-Sora

一、卓越性能:数据与效果的佐证

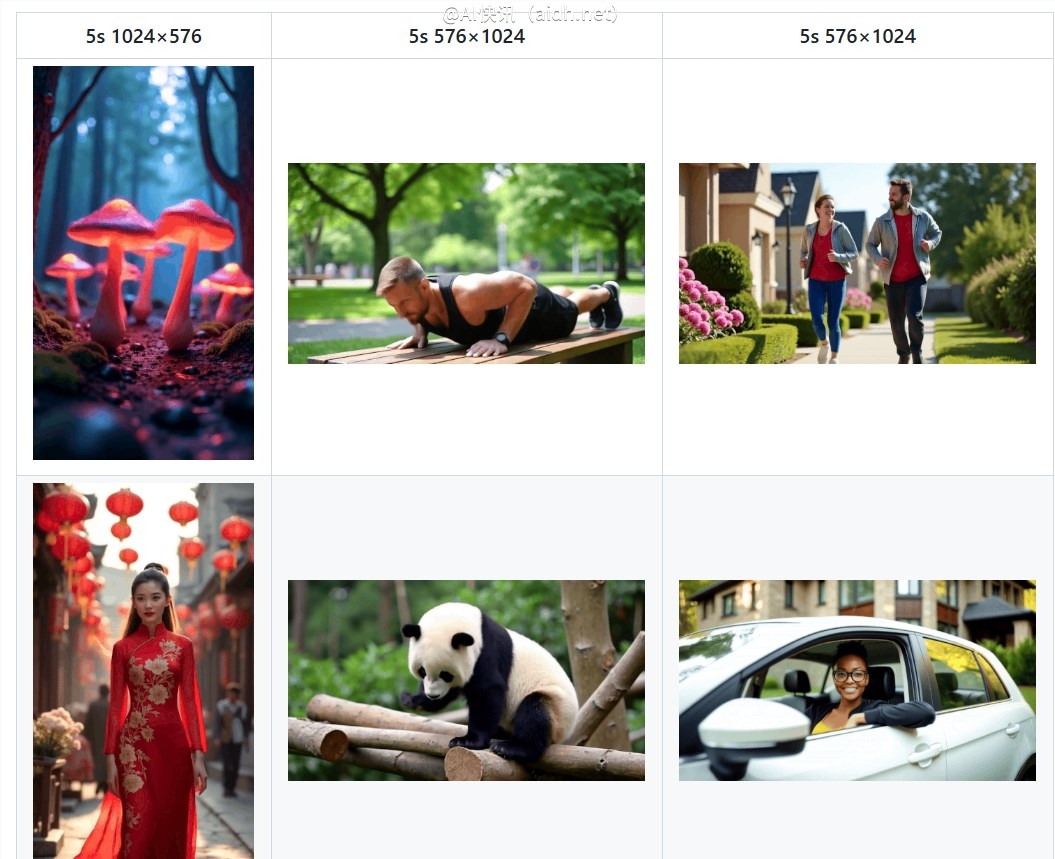

1.1 惊艳的视频演示:

Open-Sora 2.0 的视频生成效果令人印象深刻。其流畅的运镜、精准的动作捕捉、以及720p高清分辨率和24FPS的稳定帧率,使其生成的视频画面清晰流畅,超越了市面上同类产品。无论是田园风光、都市夜景,还是科幻宇宙等复杂场景,Open-Sora 2.0都能轻松驾驭,展现出丰富的细节和自然的相机运镜。

1.2 “小而强”的模型:性能直逼闭源巨头

Open-Sora 2.0 凭借其110亿的参数规模,在权威评测平台VBench和用户主观评测中均取得了优异成绩,与HunyuanVideo和30B Step-Video等闭源巨头不相上下。在视觉效果、文本一致性和动作表现三大维度上,它至少在两项指标上超越了开源SOTA模型HunyuanVideo,甚至超过了Runway Gen-3 Alpha等商业模型。在VBench榜单上,Open-Sora 2.0从1.2版本到2.0版本,与OpenAI Sora闭源模型之间的性能差距大幅缩小,甚至在某些指标上超越了腾讯HunyuanVideo,树立了开源视频生成技术的新里程碑。

二、低成本训练:开源背后的技术突破

Open-Sora团队通过技术创新,将模型训练成本降低了5-10倍,仅以20万美元的成本完成了Open-Sora 2.0的训练。 除了开源模型代码和权重外,还公开了完整的训练流程代码,构建了一个充满活力的开源生态。在短短半年内,Open-Sora的学术论文引用量已接近百次,在全球开源影响力榜单上名列前茅,成为当之无愧的“开源视频生成领头羊”。

2.1 模型架构:传承与创新的结合

Open-Sora 2.0在1.2版本的基础上进行了创新,延续了3D自编码器和Flow Matching训练框架,并保留了多桶训练机制,同时引入了多项新技术:

- 3D全注意力机制:更精准地捕捉视频中的时间和空间信息,提升画面连贯性和细节丰富度。

- MMDiT架构:更准确地理解文本指令和视频内容之间的关联,提高文生视频的语义表达精准度。

- 模型规模扩容至110亿参数:更大的模型容量提升了学习能力和生成潜力。

pen-Sora 团队深谙“garbage in, garbage out”的原则,对训练数据进行严苛筛选,确保每一份数据都达到高质量标准,从源头上提升模型训练效率。多阶段、多层次的数据筛选机制,结合多种过滤器,进一步提升了视频数据质量,为模型训练提供最优的“燃料”。

算力“精打细算”,低分辨率训练“打头阵”:高分辨率视频训练的成本远高于低分辨率视频,二者之间的算力差距可高达数十倍。Open-Sora2.0 采取了先进行低分辨率训练的策略,高效学习视频中的运动信息,在大幅降低成本的同时,确保模型掌握视频生成的“核心技能”,实现了事半功倍的效果。

策略“灵活多变”,图生视频“曲线救国”:Open-Sora2.0 并非一开始就直接进行高分辨率视频训练,而是采取了更高效的策略,优先训练图生视频模型,以加速模型收敛速度。实践证明,图生视频模型在提升分辨率时收敛速度更快,训练成本更低,实现了“一箭双雕”的效果。在推理阶段,Open-Sora2.0 还支持“文生图再生视频”(T2I2V)模式,用户可以先通过文本生成高质量图像,再将图像转化为视频,从而获得更精细的视觉效果。

并行训练“火力全开”,算力利用率“榨干最后一滴”:Open-Sora2.0 采用了高效的并行训练方案,充分利用 ColossalAI 和系统级优化技术,最大限度地提升计算资源利用率,使 GPU 集群能够“火力全开”,从而实现更高效的视频生成训练。相关技术包括:

- 序列并行 + ZeroDP:优化大规模模型分布式计算效率,实现协同效应。

- 细粒度 Gradient Checkpointing:在降低显存占用的同时,保持计算效率,实现“开源节流”。

- 训练自动恢复机制:确保绝大部分有效训练时间,减少资源浪费,实现训练过程的稳定可靠。

- 高效数据加载 + 内存管理:优化 I/O,防止训练阻塞,加速训练流程。

- 异步模型保存:减少模型存储对训练的干扰,提高 GPU 利用率。

- 算子优化:针对关键计算模块进行深度优化,加速训练过程。

通过上述优化措施,Open-Sora2.0 在高性能和低成本之间实现了平衡,大幅降低了高质量视频生成模型的训练门槛,使更多人能够参与到这项技术发展中。

2.3 高压缩比 AE “神助攻”,推理速度“再提速”

在降低训练成本的基础上,Open-Sora2.0 进一步探索高压缩比视频自编码器 (AE) 的应用,以降低推理成本,提升视频生成速度。目前主流视频模型采用 4×8×8 自编码器,生成 768px、5 秒视频,单卡耗时接近 30 分钟,推理效率亟待提升。Open-Sora2.0 训练了一款高压缩比 (4×32×32) 的视频自编码器,将推理时间缩短至单卡 3 分钟以内,速度提升了近 10 倍。

尽管高压缩比编码器具有显著优势,但其训练难度也极高。Open-Sora 团队通过在视频升降采样模块中引入残差连接,成功训练出重建质量媲美 SOTA 视频压缩模型,且压缩比更高的 VAE,为高效推理奠定了基础。同时,针对高压缩比自编码器训练数据需求大、收敛难度高等问题,Open-Sora 还提出了基于蒸馏的优化策略,并利用已训练好的高质量模型进行初始化,以减少数据和时间需求。此外,Open-Sora 重点训练图生视频任务,利用图像特征引导视频生成,加速高压缩自编码器的收敛,最终实现了推理速度和生成质量的同步提升。

Open-Sora 团队坚信,高压缩比视频自编码器将是未来视频生成技术发展的关键方向。初步实验结果已展示出显著的推理加速效果,他们希望借此吸引更多社区力量,共同探索高压缩比视频自编码器的潜力,推动高效、低成本视频生成技术的发展,使 AI 视频创作得以普及。

ttps://github.com/hpcaitech/Open-Sora”>https://github.com/hpcaitech/Open-Sora

技术报告:https://github.com/hpcaitech/Open-Sora-Demo/blob/main/paper/Open_Sora_2_tech_report.pdf

快讯中提到的AI工具