人工智能开源社区的领军平台Hugging Face最近推出了备受期待的新功能:用户可以在个人设置页面中快速查看 […]

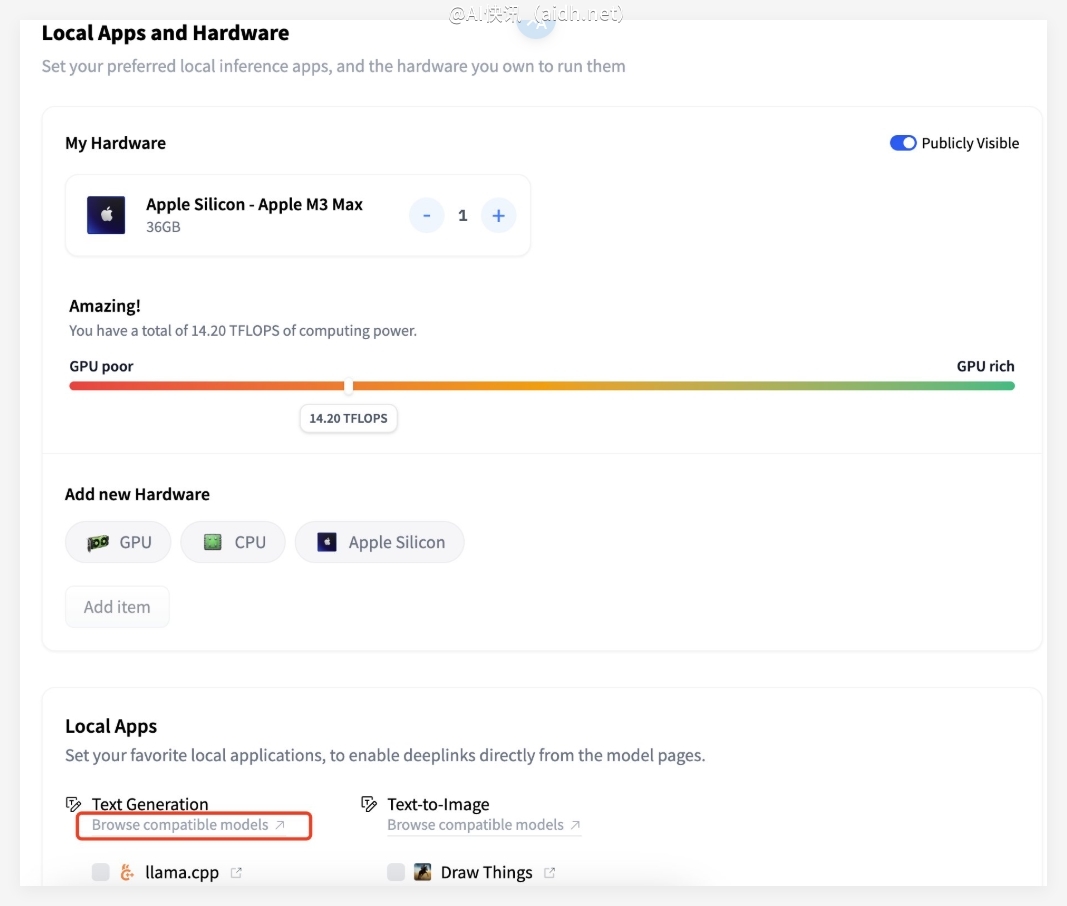

人工智能开源社区的领军平台Hugging Face最近推出了备受期待的新功能:用户可以在个人设置页面中快速查看自己的电脑硬件能够运行哪些机器学习模型。用户只需在Hugging Face的个人设置页面(路径为“右上角头像 > Settings > Local Apps and Hardware”)添加自己的硬件信息,如GPU型号、内存容量等,系统会根据这些参数智能分析并显示能够在该设备上顺利运行的模型,包括不同量化版本。这一功能的特点在于其直观性和便捷性,对开发者、研究人员和AI爱好者而言,大大简化了模型选择流程。

这一功能的使用体验也得到了用户@karminski3的肯定。他分享了自己的体验,在添加了M2Ultra(128GB内存)和Nvidia3080Ti的硬件信息后,Hugging Face的模型卡页面直接显示出M2Ultra可以运行某模型的多种量化版本,而3080Ti因性能限制无法运行,结论一目了然。

作为全球知名的AI开源平台,Hugging Face长期致力于推动人工智能技术的普及。这一新功能的推出再次彰显了其“让AI更易用”的核心理念。对于普通用户而言,判断一台电脑是否能运行某个模型通常需要一定的专业知识,而现在,这一门槛被显著降低。不论是运行LLaMA、Mistral等热门大模型,还是尝试最新的GGUF格式模型,用户都可以更轻松地上手。

此外,这一功能还与Hugging Face生态系统的其他工具形成良好互补。例如,结合平台对GGUF模型的支持,用户可以通过Ollama等本地运行工具一键部署适合自己设备的模型,进一步提升开发效率。

快讯中提到的AI工具

让AI大语言模型触手可及

机器学习和人工智能技术的平台