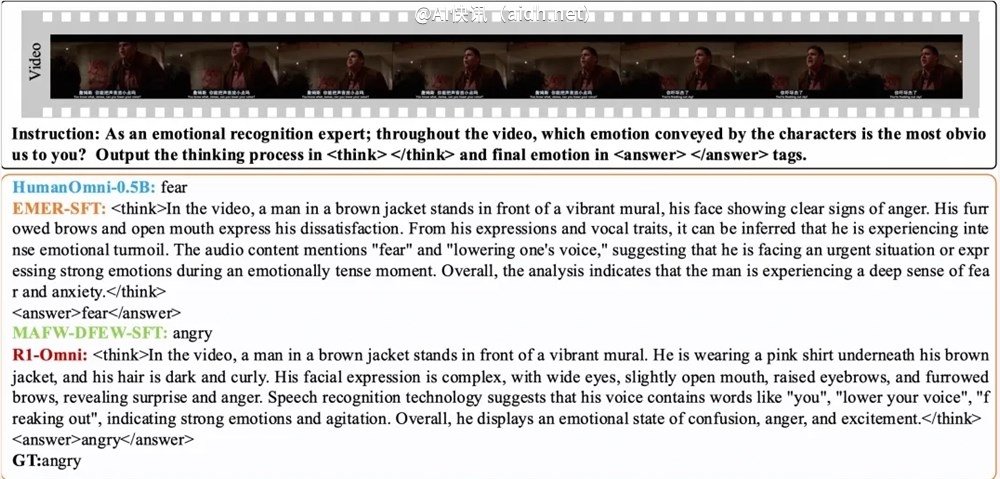

3月11日,通义实验室团队宣布开源R1-Omni模型,标志着全模态模型发展取得一项崭新突破。该模型创新性地融合 […]

3月11日,通义实验室团队宣布开源R1-Omni模型,标志着全模态模型发展取得一项崭新突破。该模型创新性地融合了强化学习与可验证奖励(RLVR)机制,着重提升多模态情感识别任务中的推理能力和泛化性能。

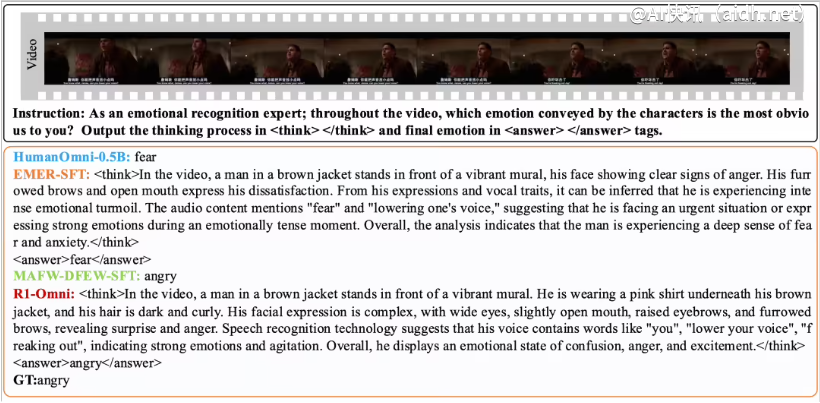

R1-Omni的训练过程分为两个关键阶段。首先是冷启动阶段,研究团队采用包含580条视频数据的综合数据集进行微调,这些数据源自Explainable Multimodal Emotion Reasoning(EMER)数据集和HumanOmni数据集。此阶段旨在为模型奠定基础推理能力,确保其在进入RLVR阶段之前,即已具备一定的多模态情感识别能力,从而保证后续训练过程的平稳性、效率与稳定性。

随后,在RLVR阶段,模型通过强化学习与可验证奖励机制得到进一步优化。此阶段的核心在于策略模型和奖励函数。策略模型负责处理由视频帧和音频流构成的多模态输入数据,进而生成带有详细推理过程的候选响应,从而清晰展示模型如何整合视觉和听觉信息以得出预测结果。奖励函数的设计则借鉴了DeepSeek R1的思路,由精确率奖励和格式奖励两部分构成,共同形成最终的奖励信号,既鼓励模型生成准确的预测,又确保输出结果结构化且符合预设格式。

实验结果表明,R1-Omni在同分布测试集DFEW和MAFW上的表现相较于原始基线模型平均提升超过35%,且与有监督微调(SFT)模型相比,在未加权平均召回率(UAR)指标上提升幅度高达10%以上。在不同分布测试集RAVDESS上,其加权平均召回率(WAR)和UAR均提升超过13%,充分展现出卓越的泛化能力。此外,R1-Omni还具备显著的透明性优势。借助RLVR方法,音频和视频信息在模型中的作用变得更加清晰,能够明确展示各模态信息对于特定情绪判断的关键影响,从而为深入理解模型决策过程和未来的研究方向提供了重要的参考依据。

论文:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

模型:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B

快讯中提到的AI工具

深度求索:引领未来人工智能技术的探索与创新