备受关注的中国人工智能研究实验室DeepSeek AI,在推出强大的开源语言模型DeepSeek-R1后,又在 […]

备受关注的中国人工智能研究实验室DeepSeek AI,在推出强大的开源语言模型DeepSeek-R1后,又在大型语言模型(LLM)领域取得了重大突破。最新推出了名为自主演原则的批判调优(SPCT)技术,旨在打造更通用、更具扩展性的AI奖励模型(RMs)。这一技术有望显著提高AI在开放任务和复杂环境中的理解和应对能力,为更智能的AI应用奠定基础。

背景部分解释了奖励模型在强化学习中的重要性,其类似于一个“裁判”,评估LLM的输出并给出相应的分数或“奖励”,从而引导模型生成更高质量的回复。然而,当前奖励模型存在一些限制,尤其在复杂、开放或主观性强的领域中,构建有效的奖励模型仍具有挑战性。

SPCT技术则是为克服现有奖励模型的局限性而提出的创新方法。研究团队强调了构建通用奖励模型需要解决的四大挑战,包括输入灵活性、准确性、推理时可扩展性和学习可扩展的行为。通过基于点的生成式奖励建模(GRM)方法,SPCT技术能够为通用任务提供所需的灵活性和可扩展性。

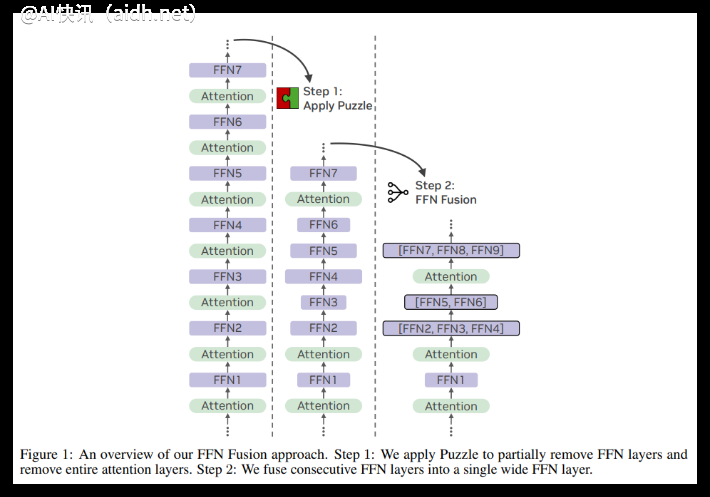

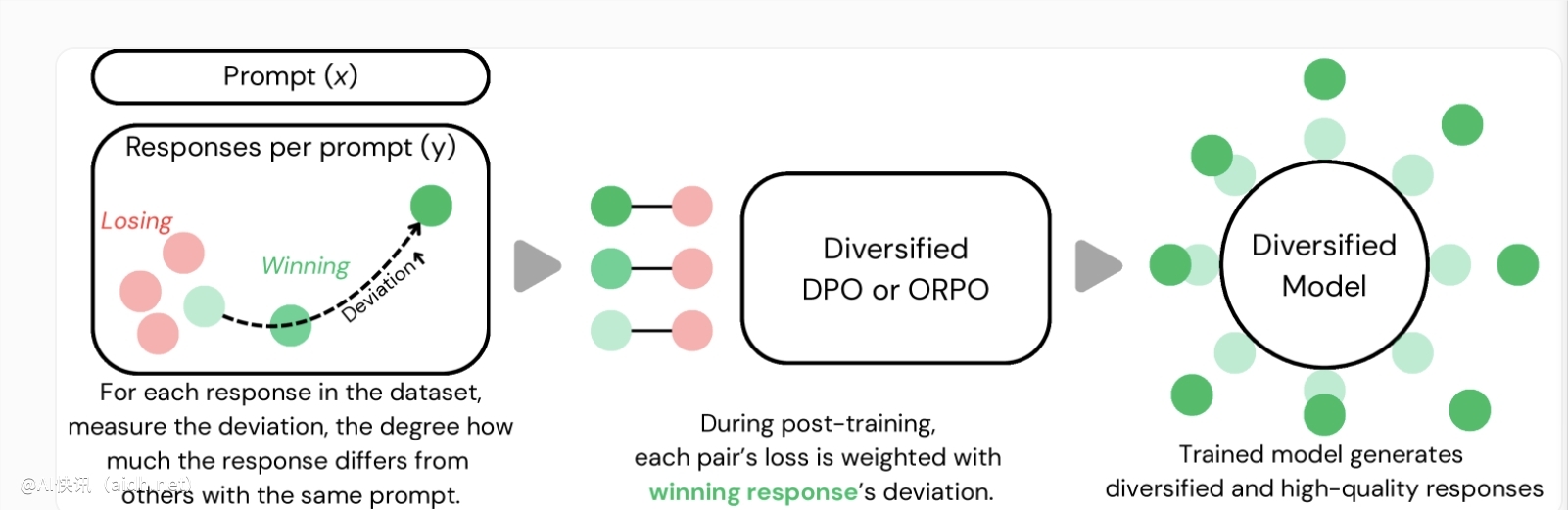

SPCT技术的核心机制包括自主演原则与批判调优,通过训练GRM根据查询和回复动态生成原则和评论。该技术包含拒绝式微调和基于规则的强化学习两个主要阶段,以提高模型的原则/评论生成能力并学习动态生成有效原则和准确评论的能力。同时,为了应对推理时可扩展性的挑战,研究人员对同一输入多次运行GRM,最终通过投票确定最终奖励,使模型能够考虑更广泛的视角,提升最终判断的准确性。a-2-27B,创建了DeepSeek-GRM-27B的情况。在多个基准测试中,他们将其与几种强大的基线RM(包括LLM-as-a-Judge、标量RM和半标量RM)以及公开模型(如GPT-4o和Nemotron-4-340B-Reward)进行了评估。结果显示,DeepSeek-GRM-27B在相同数据上训练时优于基线方法。

与标准微调相比,SPCT显著提高了奖励的质量,并提升了推理时的可扩展性。通过生成更多样本进行推理时扩展,DeepSeek-GRM-27B的性能大幅提升,甚至超过了更大的模型,如Nemotron-4-340B-Reward和GPT-4o。引入元RM进一步提升了扩展性,通过过滤判断实现了最佳结果。研究人员指出:“通过更大规模的采样,DeepSeek-GRM可以根据更多样化的原则做出更准确的判断,并输出更精细的奖励。”有趣的是,与在可验证任务上表现良好但在其他方面表现较差的标量RM相比,SPCT在不同领域表现出更少的偏差。

更通用和可扩展的奖励模型的开发对于企业级AI应用具有广阔的前景。潜在的受益领域包括创意任务以及模型必须适应动态环境(如不断变化的客户偏好)的应用。尽管取得了显著的成果,但与非生成式RM相比,DeepSeek-GRM在纯粹可验证的任务上的性能以及效率方面仍然存在挑战。DeepSeek 团队表示,未来的工作将侧重于提高效率和更深入的集成,可能包括将GRM集成到在线RL流程中、作为奖励系统的通用接口,探索与策略模型进行推理时协同扩展,或作为基础模型的鲁棒离线评估器。

快讯中提到的AI工具