基于 Gemini 2.0 打造的一款出色的工具

基于 Gemini 2.0 打造的一款出色的工具

OpenAI 发布的最新一代语言模型

OpenAI 推出的最新小型模型

OpenAI 最新的旗舰模型

字节跳动推出的自研大模型

中国版对话语言模型,与GLM大模型进行对话

OpenAI开发的一款先进AI聊天机器人

推动AGI发展的高效AI平台

让AI大语言模型触手可及

产业级知识增强大模型

人工智能应用程序和AI聊天机器人

科大讯飞推出的新一代认知智能大模型

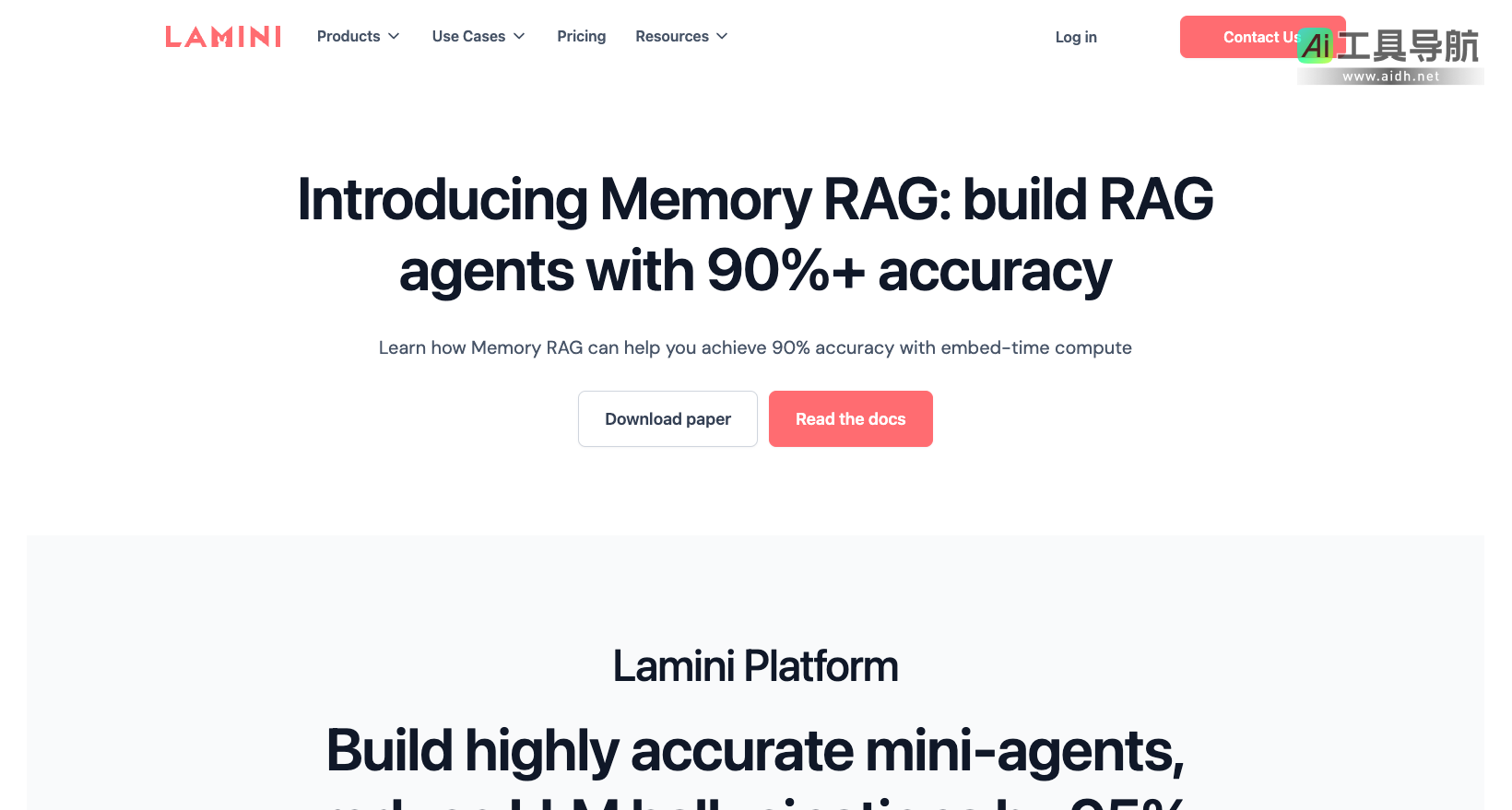

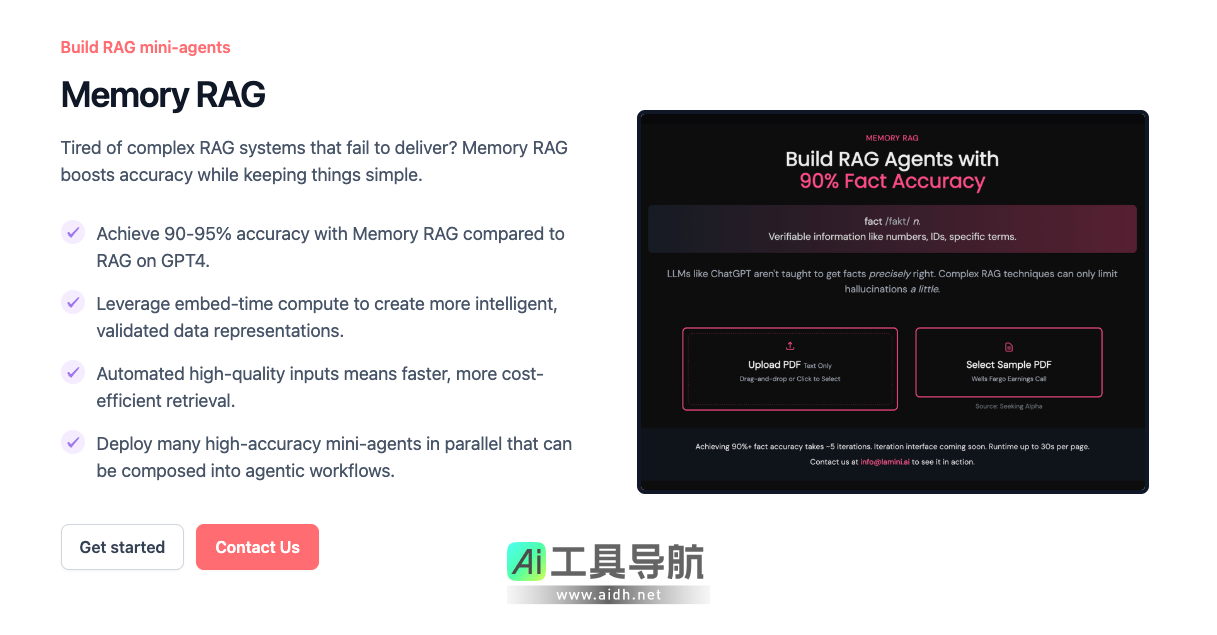

在人工智能的迅猛发展中,企业对于高精度、大规模可控的LLM(大语言模型)需求日益增加。Lamini作为企业级LLM平台,致力于帮助现有软件团队快速开发、训练和部署自有大语言模型,同时确保高精度、低幻觉(hallucination)、安全合规,实现AI能力的企业级落地。

Lamini专注于构建企业级LLM应用,其Memory RAG(检索增强生成)技术可将幻觉率降低95%,并提供文本分类、文本转SQL、函数调用等关键能力。凭借与AMD的深度合作,Lamini成为唯一能在AMD GPU上高效运行和扩展至数千节点的LLM平台,现已广泛应用于财富500强企业和顶级AI初创公司。

在LLM实际应用中,幻觉(hallucination)是企业落地AI时遇到的重大挑战。Lamini的Memory RAG技术通过嵌入时计算(embed-time compute),实现比GPT-4标准RAG模型高达90%-95%的准确率,有效提升数据检索、内容生成的可靠性。

Memory RAG的核心优势:

如果企业希望构建一个高精度、可控、可扩展的RAG系统,Memory RAG是目前市场上最具竞争力的解决方案之一。

Lamini的Classifier Agent Toolkit是一款专为大规模数据分类设计的AI工具,能够自动完成数据标注、文本分类、意图识别等任务,极大提升企业的数据处理效率。

主要功能:

对于需要高效处理非结构化数据的企业,Lamini的Classifier Agent Toolkit能帮助减少人工分类工作量,并提高数据利用效率。

Lamini的Text-to-SQL智能体,能够将自然语言转换为SQL查询,让企业团队无需SQL经验也能轻松访问数据库,进行业务分析和决策。

核心能力:

这对于财务、市场分析、运营管理等团队来说,Text-to-SQL工具可以极大减少数据分析门槛,提升决策效率。

Lamini的Function Calling能力,让LLM能够自动连接外部工具、API,执行更复杂的自动化任务,例如:

来自AI导航网(aidh.net)编辑部门整理。

Lamini的Function Calling极大提升了LLM的交互性和自动化能力,适用于智能助手、工作流自动化、企业IT运维等场景。

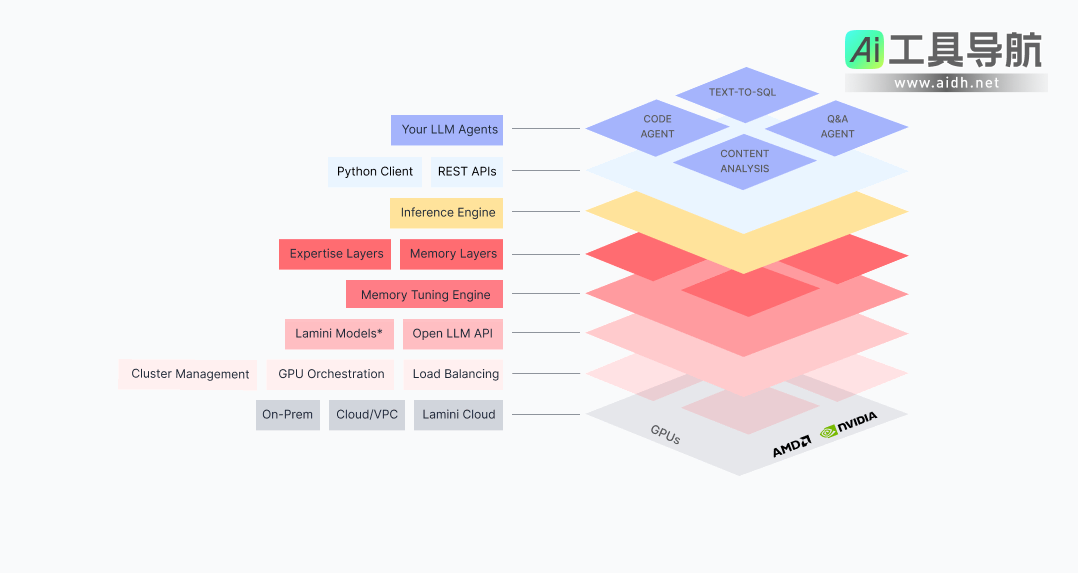

为了满足企业对于数据安全和合规性的高要求,Lamini提供灵活的部署模式,包括:

对于需要保证数据隐私、安全性、合规性的企业,Lamini提供了一套安全可靠的LLM解决方案,可适配不同业务需求。

1. 专为企业优化,提升LLM可靠性

Lamini不仅仅是一个AI模型,而是一个完整的企业级LLM开发平台,具备高精度训练、数据优化、低成本推理等能力。

2. Memory RAG,彻底降低幻觉问题

Lamini的Memory RAG技术,可减少95%的AI幻觉现象,让企业可以构建更可靠的智能体,避免错误信息传播。

3. 支持大规模数据分类与自动化

企业可以利用Classifier Agent Toolkit,自动化处理海量非结构化数据,提升数据利用率。

4. 快速Text-to-SQL转换,降低数据分析门槛

通过自然语言生成SQL查询,Lamini让非技术人员也能轻松访问数据库,实现高效的数据驱动决策。

5. Function Calling让AI真正可用

Lamini支持自动调用外部API,帮助企业实现AI驱动的自动化任务,优化工作流。

6. 安全可控,支持本地与云端部署

Lamini可以本地化部署(On-Premise),满足金融、医疗、政府等行业对数据安全的严格要求。

1. 访问Lamini官网,申请试用

Lamini提供**$300美金免费试用额度**,企业可以先体验Memory RAG、Text-to-SQL、Classifier Agent等功能。

2. 选择合适的部署方式

根据企业需求,选择云端(VPC)或本地部署(On-Premise),确保数据安全。

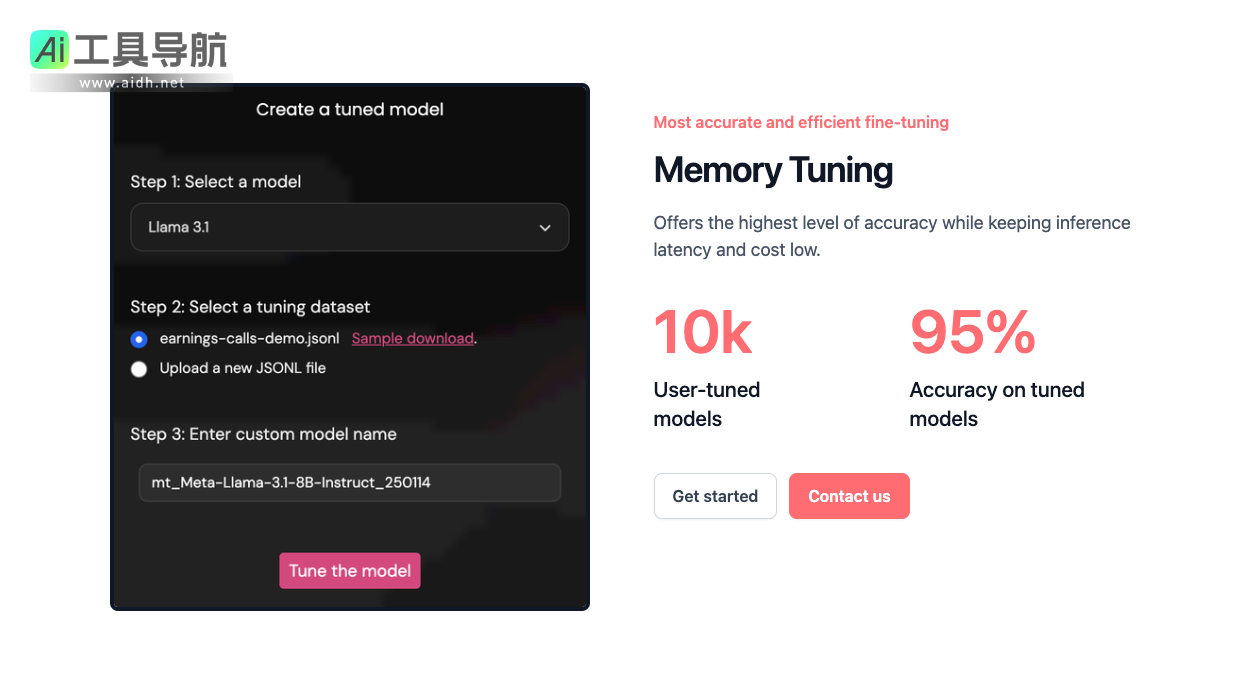

3. 结合企业数据,优化LLM模型

使用Lamini的Memory Tuning技术,将企业专属数据整合到LLM中,提高模型的准确性和行业适配性。

4. 运行智能代理,实现自动化

部署RAG智能体、SQL查询、分类工具,在企业内部大规模应用Lamini,提高生产力。