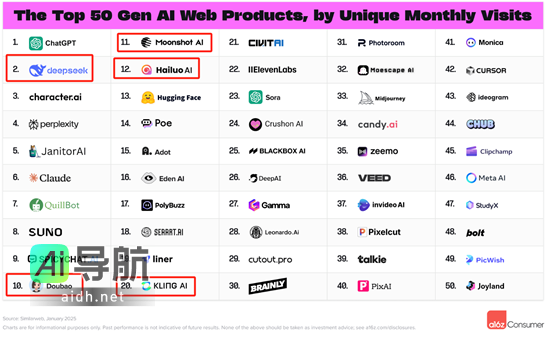

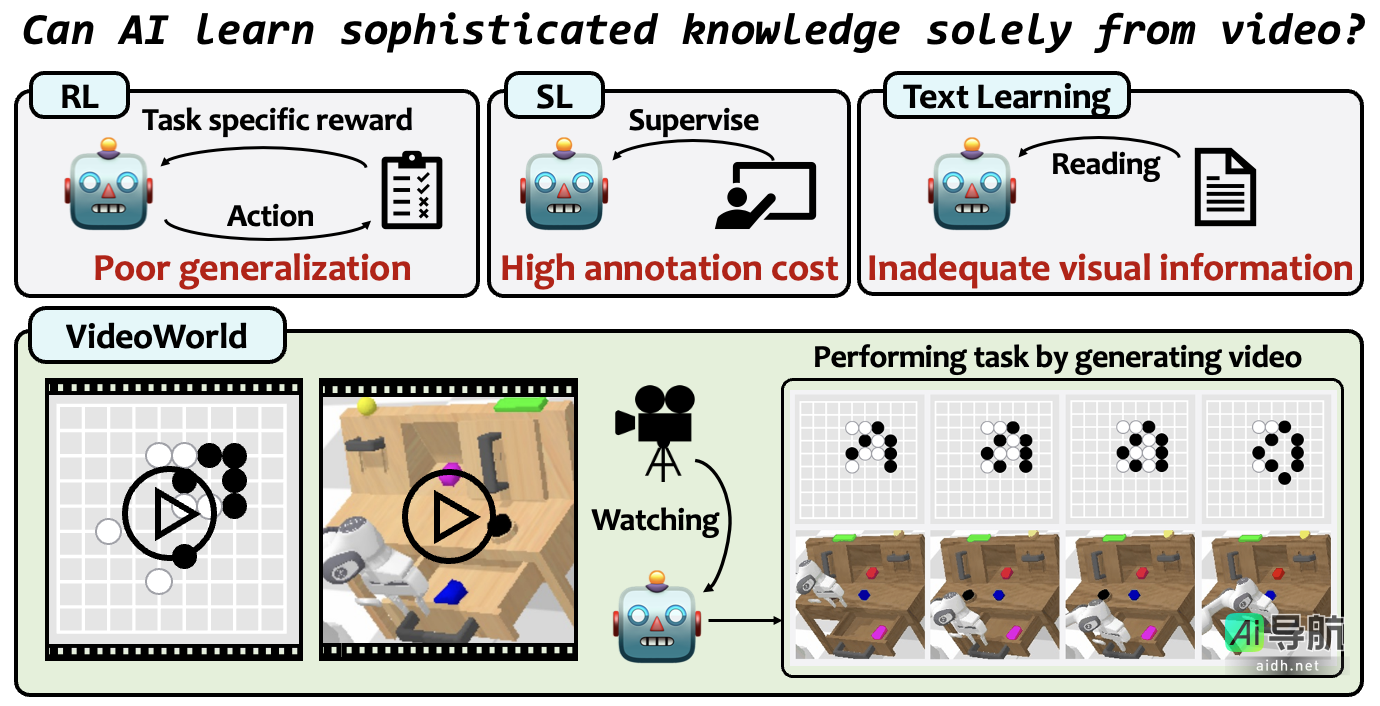

豆包大模型团队联合北京交通大学、中国科学技术大学,于近日宣布开源其共同研发的视频生成实验模型“VideoWorld”。该模型与Sora、DALL-E、Midjourney等主流多模态模型的主要区别在于,VideoWorld在业界率先实现了不依赖于语言模型即可认知世界的能力。

据悉,目前多数模型在学习知识时,高度依赖语言或标签数据,而对纯视觉信号的学习相对较少。然而,语言在捕捉真实世界中的所有知识方面存在局限性。例如,折纸、打领结等复杂任务难以通过语言进行清晰而详尽的表达。VideoWorld摒弃了语言模型,从而实现了统一执行理解和推理任务的能力。

此外,VideoWorld基于一种潜在动态模型,能够高效压缩视频帧间的变化信息,从而显著提高知识学习的效率和效果。在不依赖任何强化学习搜索或奖励函数机制的前提下,VideoWorld达到了专业5段9×9围棋的水平,并能够在多种环境中执行机器人任务。

AI工具库提供的相关链接如下:

- 论文链接:https://arxiv.org/abs/2501.09781

- 代码链接:https://github.com/bytedance/VideoWorld

- 项目主页:https://maverickren.github.io/VideoWorld.github.io

文章中提到的AI工具

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关AI热点

暂无评论...