ModelScope平台全新发布了P-MMEval大模型评估基准,它全面衡量大型语言模型(LLM)的能力,涵盖 […]

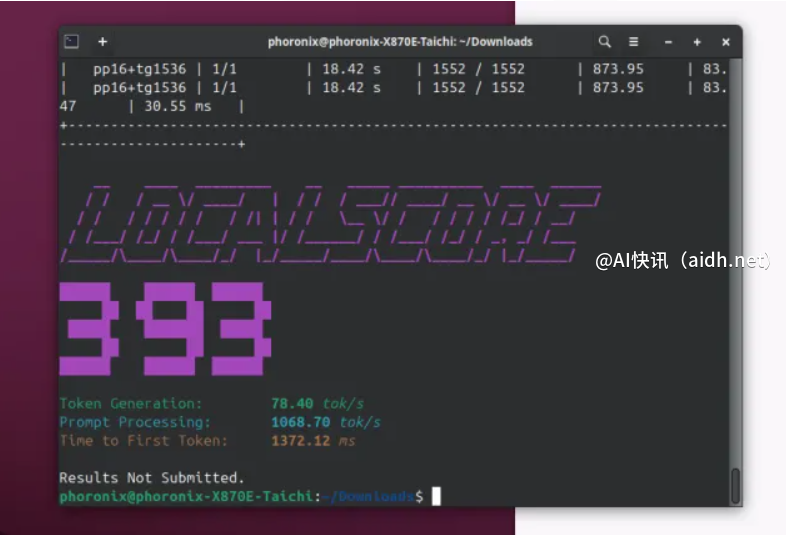

ModelScope平台全新发布了P-MMEval大模型评估基准,它全面衡量大型语言模型(LLM)的能力,涵盖多个维度,并提供详尽的评估报告。该基准能够客观地评估LLM的性能,帮助开发者改进模型,提升其在实际应用中的表现。

P-MMEval基准拥有丰富的评测维度,能够细致地评估大型语言模型的各项能力,并生成直观的评估报告,方便开发者了解模型的优缺点。它能够有效地帮助开发者改进模型,从而提升其在实际应用中的效果,是模型开发过程中的重要工具。

P-MMEval基准采用多维度评测指标,对大型语言模型进行全面评估,并提供详细的评估结果报告,方便用户直观地了解模型的性能。该基准能够有效地帮助用户选择合适的模型,并促进模型的持续改进,从而提升其在实际应用中的效果。

P-MMEval基准与OpenCompass和EvalScope等其他评估平台互补,共同构建更全面的模型评估体系。它拓展了模型评估的广度和深度,为开发者提供更完善的模型评估工具,推动大型语言模型技术的进步。P-MMEval的数据集全面覆盖了多种评估场景,并对结果进行了详细的分析,为开发者提供更全面的模型评估服务,从而提高模型的性能和可靠性。

为了方便用户使用,我们提供了丰富的模型评测方法以及详尽的评测结果报告。此外,我们支持GPT-4、Claude-3.5、LLaMA3.1、LLaMA3.2、Qwen-2.5等多个主流的大型语言模型,并根据评测结果对这些模型进行了排名,方便用户进行比较和选择。同时,我们也对不同模型的优缺点进行了分析,为用户提供更全面的参考。

P-MMEval基准致力于提供一个全面、客观、高效的大型语言模型评估平台。它通过多维度评测指标和详尽的评估报告,帮助开发者更好地了解模型的性能,并改进模型的不足之处,最终促进大型语言模型技术的快速发展。

数据集地址:

https://www.modelscope.cn/datasets/modelscope/P-MMEval

快讯中提到的AI工具