Meta Platforms近来发布了其Llama语言模型的更新版本,其中包括Llama 3的21B和8B两个参数规模的模型,旨在提升开源社区中大型语言模型的可访问性和性能。这些新模型在特定基准测试中表现出色,能够更好地处理复杂任务和生成高质量的文本。与之前的模型相比,性能得到了显著提升,例如在某些指标上提高了56%,在常识推理方面提高了41%,使其能够更有效地回答需要多个步骤的复杂问题,并能处理8,000个token的序列长度。

在Android平台的集成方面,Meta利用AI模型压缩技术(如SpinQuant和QLoRA)来优化模型大小,从而减少计算资源的占用。这种优化使得这些模型能够在资源受限的设备上运行,同时保持良好的性能。这些模型已成功地移植到移动设备上,并且经过了精心的调优。

针对OnePlus 12手机的专门适配,展示了这些语言模型如何在移动设备上实现高效运行,即便在资源有限的情况下。这些模型经过优化,能够利用移动设备的计算能力,同时减少对电池寿命的影响,能够在本地实现高级推理和生成任务,无需依赖云端服务器。Meta希望通过优化其AI模型,为终端用户提供更强大的功能,并促进设备上的AI创新,使其能够支持Llama系列模型及Hugging Face等其他开源模型,从而赋能开发者构建创新的移动应用。

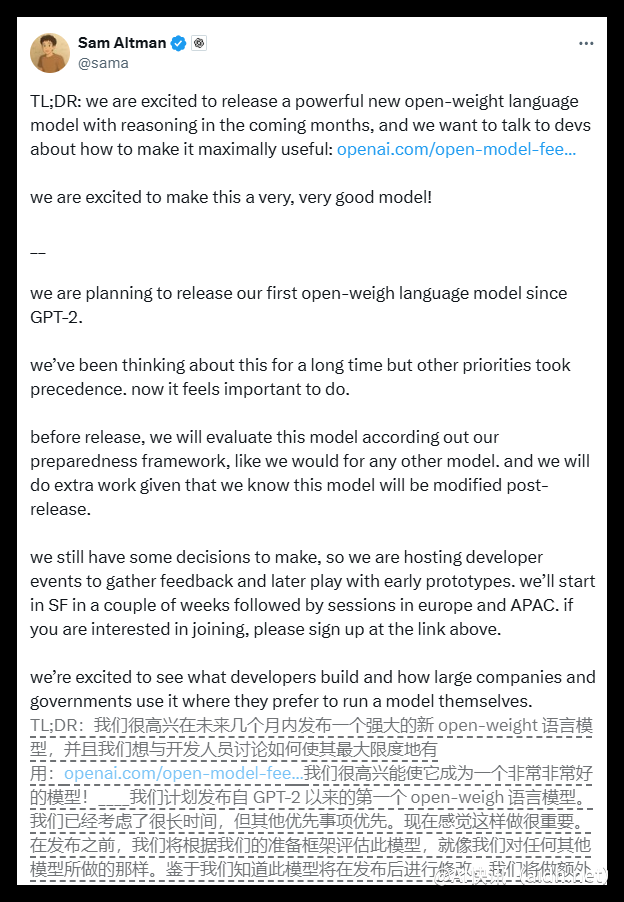

这一系列的进展标志着在更广泛的设备上部署先进人工智能技术的重要一步。通过提供这些优化的模型,Meta的目标是降低AI开发的门槛,使更多的开发者能够利用这些技术来创建更智能的应用程序和服务。开放其语言模型的权重,能让更多的人参与到模型的改进和定制中,进而推动整个生态系统的发展。同时,该模型也为研究领域提供了宝贵的资源,加速了人工智能领域的创新。

总而言之,这些更新代表了在将强大的人工智能技术带给更广泛受众方面迈出的重要一步,其潜在的应用场景非常广泛,包括增强移动应用、改进虚拟助手和支持各种创新项目。Meta积极推动开源社区的发展,旨在促进创新和合作,为人工智能技术的未来发展奠定基础。通过使这些模型更容易访问,Meta希望激发更多的创造性应用,并加速人工智能技术的普及。

快讯中提到的AI工具

Hugging Face

机器学习和人工智能技术的平台

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/shbu2qn9

暂无评论...