当前人工智能领域发展迅速,但开发者和组织面临着计算需求高、延迟大以及缺乏真正灵活的开源模型等实际挑战。这些挑战 […]

当前人工智能领域发展迅速,但开发者和组织面临着计算需求高、延迟大以及缺乏真正灵活的开源模型等实际挑战。这些挑战限制了人工智能的应用,许多现有解决方案依赖昂贵的云基础设施或体积过大,无法在本地设备上部署。因此,高效灵活的模型需求迫切。

为此,Reka AI 推出了 Reka Flash3,一个参数量为 21 亿的全新推理模型。该模型旨在支持通用对话、代码辅助、指令遵循甚至函数调用,可作为各种应用的基础模型。其训练数据结合了公开数据集和合成数据集,并通过精心设计的指令微调和 REINFORCE Leave One-Out (RLOO) 方法进行强化学习,力求在模型能力和效率之间取得平衡。

Reka Flash3 具备多项技术特性,使其兼具灵活性和资源效率。其显著特点包括:支持长达 32k 个 token 的上下文长度,能够轻松处理长文档和复杂任务;引入了“预算强制”机制,用户可通过 <reasoning> 标签限制模型的推理步骤,在不增加计算成本的情况下保持性能稳定;模型体积小巧,全精度大小为 39GB (fp16),4 位量化后可压缩至 11GB,非常适合本地部署。

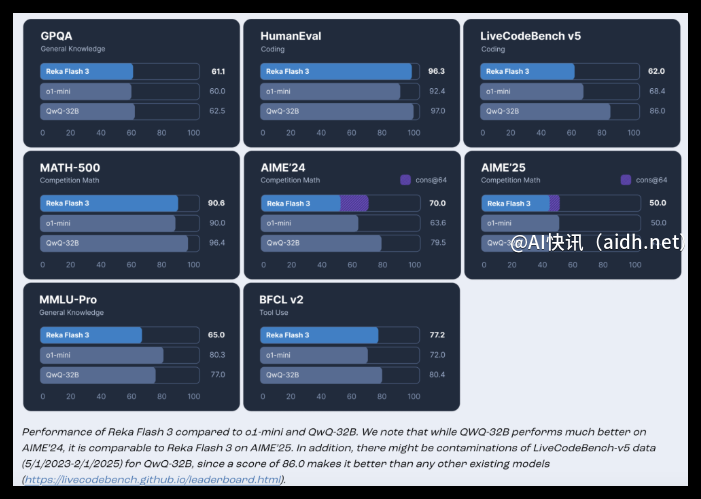

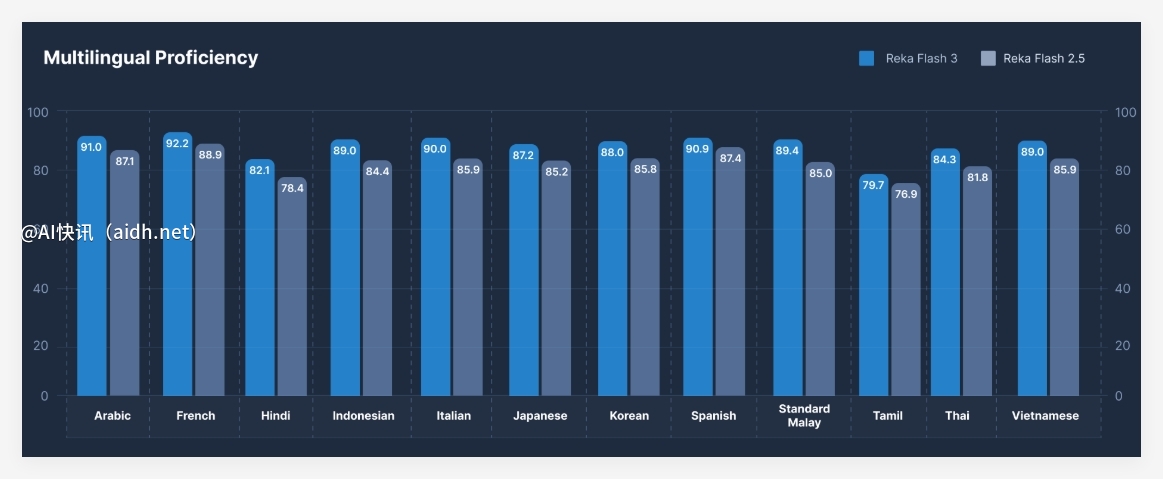

模型性能评估结果也证实了其实用性。虽然 Reka Flash3 在 MMLU-Pro 上的得分(65.0)为中等水平,但结合网络搜索等外部知识源后,其竞争力将显著提升。此外,其在 WMT’23 COMET 上的得分达到 83.2,表明其具备良好的多语言能力,尽管主要针对英语。相较于 QwQ-32B 等同类模型,Reka Flash3 参数量更少,效率更高,展现出其在实际应用中的巨大潜力。

总之,Reka Flash3 提供了一种更易于访问的人工智能解决方案。它在性能和效率之间取得了巧妙的平衡,为通用对话、代码辅助和指令遵循任务提供了一个稳健而灵活的选择。其紧凑的设计、增强的 32k token 上下文窗口以及创新的“预算强制”机制使其成为本地部署和低延迟应用的理想选择。对于寻求兼具强大功能和易于管理的模型的研究人员和开发者而言,Reka Flash3 无疑是一个极具吸引力的基础模型。

介绍: https://www.reka.ai/news/introducing-reka-flash

模型: https://huggingface.co/RekaAI/reka-flash-3

要点:

- Reka Flash3 是 Reka AI 推出的一个开源推理模型,参数量为 21 亿,适用于多种应用场景。

- 该模型支持 32k token 的上下文处理,能够高效处理复杂任务,并支持本地设备运行。

- 性能数据表明,Reka Flash3 在多语言能力和实际应用中表现出色,是一款易于访问的 AI 解决方案。