摘要:

在大型语言模型的评估中,针对中文环境下的推理能力测评一直存在挑战。为了解决这个问题,来自中国人民大学的研究团队 […]

在大型语言模型的评估中,针对中文环境下的推理能力测评一直存在挑战。为了解决这个问题,来自中国人民大学的研究团队开发了一种新的基准测试方法,旨在更准确地评估中文语言模型的能力。这种基准测试的设计目标是能够有效区分不同模型的优劣。

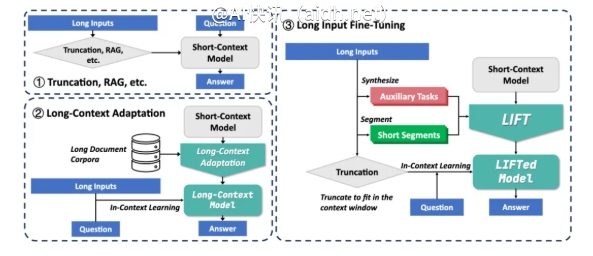

为了更全面地评估中文语言模型,研究团队提出了一个名为“涌现差分”的框架。该框架通过比较模型在不同步骤中的表现,来衡量其推理能力。具体的步骤包括Step推理轨迹描述、选择推理路径以及给出最终答案,以此来考察模型在解决复杂问题时的逐步推理能力。

具体来说,该框架借鉴了LiveBench和LMSYS Chatbot Arena的思路,将Step-2模型和Step-1模型进行V型对比,从而评估中文语言模型的性能。这种“涌现差分”方法的核心在于考察模型在逐步推理过程中的表现,通过分析推理路径的选择以及最终答案的准确性,来判断模型是否具备真正的推理能力。

值得一提的是,CEO创始人兼首席执行官表示,他们一直在寻找能够精确衡量AI能力的基准,从而更好地理解模型的推理过程。传统的评估方法,如ResNet等,往往难以捕捉到模型在推理过程中的细微差别。而该研究提出的Step-1方法,通过对比不同步骤的表现,能够更准确地评估模型的推理能力,并为模型优化提供有价值的参考。

总而言之,这种“逐步推理+差异对比”的方法为评估中文语言模型的推理能力提供了一个新的视角。研究团队通过引入“涌现”这一概念,并结合OPPO等实际场景,旨在更全面地评估语言模型在复杂任务中的推理能力。在未来的研究中,有望将这种方法应用于更多的语言模型评估中,为推动人工智能技术的发展做出贡献。

© 版权声明:

文章版权归作者所有,未经允许请勿转载。

本文地址:https://aidh.net/kuaixun/phr7k6cg

暂无评论...