在多模态大型语言模型 (MLLMs) 的领域中,理解、生成以及处理多模态信息的复杂能力,一直是研究的核心和挑战 […]

在多模态大型语言模型 (MLLMs) 的领域中,理解、生成以及处理多模态信息的复杂能力,一直是研究的核心和挑战。近期,涌现出能够执行视觉推理、知识整合以及复杂任务处理的新模型。

这些能力使得新一代的多模态模型,在解决现实世界问题上展现出巨大的潜力。本文将深入研究这些模型在理解和生成方面的最新进展,从而揭示其非凡之处。

值得关注的是,近期涌现的具有代表性的多模态模型,在理解和生成能力上取得了显著进展,它们能够执行视觉推理、知识整合等复杂任务,并展示出令人印象深刻的性能。以下将重点介绍 MLLMs 在多模态理解和生成方面取得的突破,以及它们在现实世界中的应用潜力。

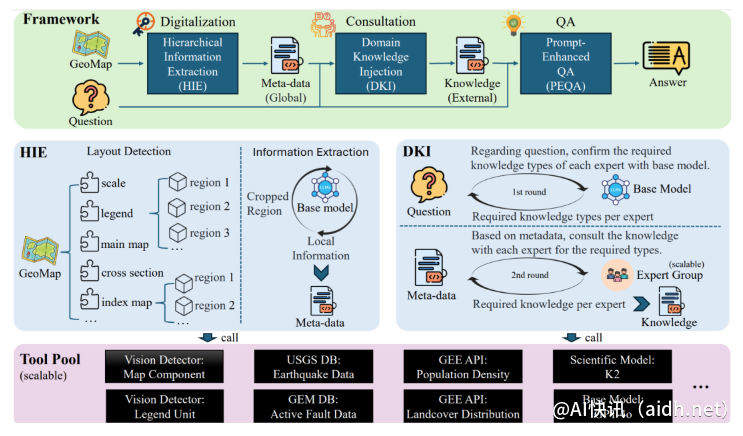

理解多模态信息交互的关键:多模态大型语言模型 (MLLMs) 及其应用。MLLMs 旨在弥合视觉和语言理解之间的差距,优于传统的 LLMs,它们只能处理文本信息,例如 LLaVA。此外,研究者们还专注于提升多模态交互的性能,例如 LLaVA-OneVision。当前,研究者们正在努力开发能够更有效地处理图像、文本和音频等多种信息形式的模型。

例如,UC Merced、航空图像数据集、文本和图像数据集的基准测试了 Sa2VA,这是一个多模态统一模型,能够执行复杂的多模态推理任务。这些模型通过整合视觉和语言信息,提高了各种任务的性能,为多模态大型语言模型的发展做出了贡献。

Sa2VA 的设计灵感来源于 SAM-2 和 LLaVA 模型,集成了视觉、语言和多模态任务的 LLM 能力。此外,该团队还利用 Ref-SAV 的提示工程策略和72K 多模态指令微调数据,以及2K 任务相关的多模态指令,进一步优化了模型的性能。

Sa2VA 的主要贡献包含以下几个方面:结合 LLaVA 的架构和 SAM-2,实现了一种通用的视觉语言模型。与 LLaVA-like 模型相比,它扩展了视觉和语言的任务处理能力,并融合了来自 SAM-2 的图像分割能力。通过利用提示工程策略,它还提高了现有 MLLMs 的性能水平。

值得一提的是,Sa2VA 在多项基准测试中表现出色,Sa2VA-8B 模型在 RefCOCO、RefCOCO + 和 RefCOCOg 的 cIoU 指标上分别达到了 81.6、76.2 和 78.9,超过了 GLaMM-7B 模型的性能。此外,Sa2VA 在 MME、MMbench 和 SEED-Bench 上也取得了优异的成绩,分别达到了 2128、81.6 和 75.1 的分数。

总之,Sa2VA 在视觉理解领域取得了重大突破,超越了当前最先进的 VISA-13B,提升了多模态理解和生成领域的研究水平。

论文:https://arxiv.org/abs/2501.04001

模型:https://huggingface.co/collections/ByteDance/sa2va-model-zoo-677e3084d71b5f108d00e093

核心要点:

✨ Sa2VA 是一款强大的 AI 模型,它结合了视觉与语言处理能力,实现了卓越的多模态交互,促进了多模态模型的发展。

⭐ 该模型在多个基准测试中取得了领先的成绩,证明了其在复杂视觉语言任务上的卓越性能,为未来的研究奠定了基础。

🧠 Sa2VA 的架构设计融合了图像分割和视觉语言能力,极大地提高了多模态交互的性能,推动了多模态领域的发展。