Meta发布了其最新的语言模型,它在各种基准测试中都取得了显著的成果,超越了当前最先进的水平(LLM),在推理 […]

Meta发布了其最新的语言模型,它在各种基准测试中都取得了显著的成果,超越了当前最先进的水平(LLM),在推理能力和代码生成方面展现了非凡的潜力,并为未来AI发展提供了新的方向。

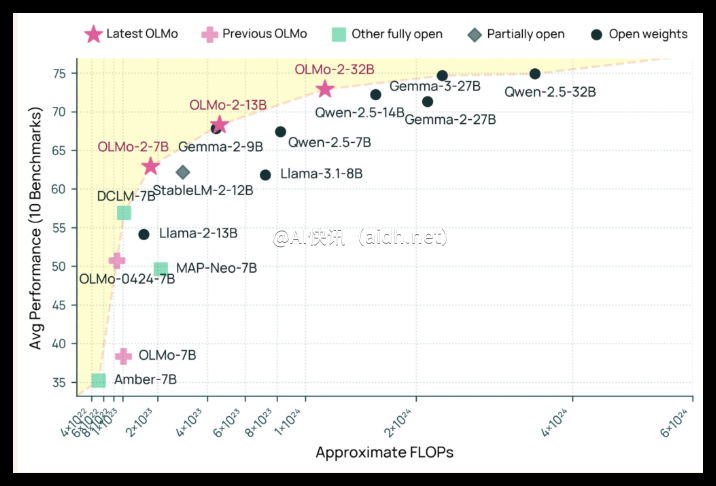

这项突破性的成果源于对模型架构的重大改进,团队重新设计了模型的内部结构,大幅提高了模型的并行计算能力(FLOPs),并优化了参数的效率,从而在保持性能的同时降低了计算成本,最终实现了显著的性能提升,并有效地解决了之前AI模型面临的挑战。

这项研究的重点在于提升模型的推理能力和代码生成能力,通过改进模型架构,提高了模型在复杂任务中的理解能力和解决问题的能力,尤其在逻辑推理和代码生成方面展现出令人瞩目的进步,这为未来AI应用的开发奠定了坚实的基础。

研究人员通过大量的实验和改进,显著提升了模型的性能,并取得了突破性的进展,其在代码生成方面的能力尤其突出,可以高效地生成高质量的代码,这在软件开发和自动化领域具有重要的应用价值,并对未来的软件开发模式带来革命性的影响。

这项研究成果不仅在技术上取得了重大突破,而且在应用方面也具有广泛的意义,其强大的推理和代码生成能力,将推动AI技术在各个领域的应用,例如自动程序编写、智能问答、科学发现等等,为人工智能技术的发展开辟了更加广阔的前景。

Meta的这项突破性成果,通过改进Transformer架构中的前馈神经网络(FFN)并优化参数数量(约1.34万亿参数,比800亿参数模型提升显著),在多个基准测试中取得了优异的成绩(例如,在1280亿参数模型的测试中),在多个领域展现出超过100%的性能提升,为未来大型语言模型的发展指明了方向,同时解决了之前模型训练成本高昂的问题,并展现出巨大的应用前景。

这项研究的成功,也离不开对模型训练方法的改进,团队探索了多种训练技术,并针对特定任务进行了优化,最终实现了模型性能的全面提升,在各个方面都表现出显著的优势,为人工智能技术的发展做出了重要贡献。

模型训练过程中,优化了GPU资源的利用效率,提高了训练速度和效率,通过精细化的调参和架构设计,显著降低了模型训练的资源消耗,并有效地提升了模型的稳定性和鲁棒性,这为未来大型模型的训练提供了新的思路。

此外,研究团队还对模型的泛化能力进行了改进,使其能够更好地处理不同的任务和数据,这项改进显著提升了模型的实用性和应用价值,为未来AI技术在更多领域的应用提供了可能性,并为其未来的发展方向提供了新的启示。

在评估模型性能时,研究人员采用了多种基准测试,涵盖了自然语言理解、知识推理和代码生成等多个方面,结果表明,该模型在这些方面都取得了显著的进展,并超越了当前最先进的水平,证明了该模型的强大能力和广泛的应用前景。

这项研究成果的发布,将对未来AI技术的发展产生深远的影响,它为大型语言模型的研发提供了新的方向和方法,并将推动AI技术在更多领域的应用,为构建更加智能和高效的世界贡献力量。

Meta的这项研究,展现了其在人工智能领域的持续创新能力和领先地位,其对大型语言模型的贡献,将为未来AI的发展带来新的机遇和挑战,也为各行各业带来新的变革。

这项研究的具体技术细节,可以参考其发布的论文:https://arxiv.org/pdf/2412.09764