大型语言模型,例如GPT-4o、Gemini 1.5 Pro和Llama-3-70B等12个先进AI模型,正在 […]

大型语言模型,例如GPT-4o、Gemini 1.5 Pro和Llama-3-70B等12个先进AI模型,正在被用于探索Adobe Research最新的生成对话技术,旨在提升用户体验并优化交互流程。这些模型处理的上下文窗口长度高达128,000个token,能够更全面地理解对话内容,从而实现更具深度和个性化的交流。

NOLIMA,即噪声条件下的无损语言模型评估方法,被设计用于评估AI模型在处理复杂对话场景时的性能,通过模拟真实世界的挑战,揭示AI模型在各种条件下的优势和局限。例如,当询问“Yuki在Semperoper演出吗?”,模型需要理解“Semperoper的演出日程”的语境,才能给出准确的回答。

评估重点:

1. 上下文理解能力:考察模型能否在2,000到8,000个token的范围内理解对话内容,并根据上下文生成相关的回应;在32,000个token的长程上下文中,评估12个AI模型处理10个不同领域任务的表现。

2. 噪声环境下的鲁棒性:评估AI模型在存在干扰信息的情况下,是否能够准确理解用户意图,并生成有意义的回复。

3. 长程依赖建模能力:在o1、o3-mini和DeepSeek-R1等模型中,32K token的NOLIMA-Hard测试集上的准确率降低超过50%,但在大型语言模型中仍表现出色。

对话系统正在朝着更加智能化的方向发展,未来的关键在于提升模型的推理能力。研究表明,通过引入思维链(CoT)技术,Llama-3-70B模型的上下文学习能力得到了显著提升。这意味着,即使在噪声环境下,大型语言模型也能更有效地进行对话。

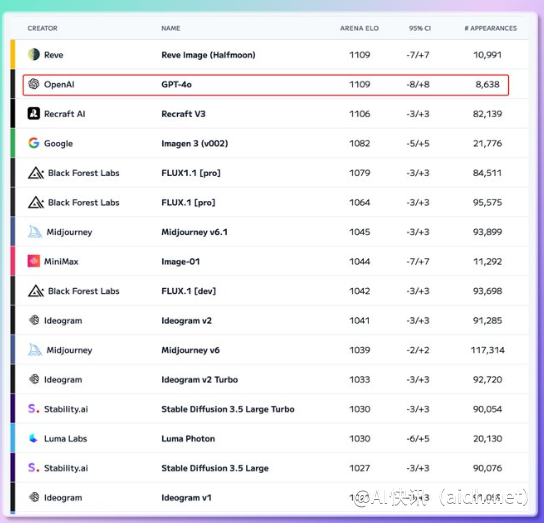

Adobe研究人员表示:“这表明AI模型的语言理解能力正在快速发展,能够更好地处理复杂对话。”相对于GPT-4o,研究发现,在处理8,000个token的短程上下文时,其他一些开源模型也能实现具有竞争力的性能。此外,AI模型在噪声环境下的鲁棒性也得到了显著提升,能够更准确地理解用户意图。

总而言之,AI技术的发展正在推动对话系统向更高水平迈进:更强的上下文理解能力、更高的噪声抵抗能力以及更出色的推理能力。这些进步将有助于AI更好地理解人类语言,从而实现更自然、更高效的对话。

快讯中提到的AI工具