近期,领先的人工智能公司OpenAI正式推出了Evals API,这一全新工具的推出立即引起了开发者和技术圈的 […]

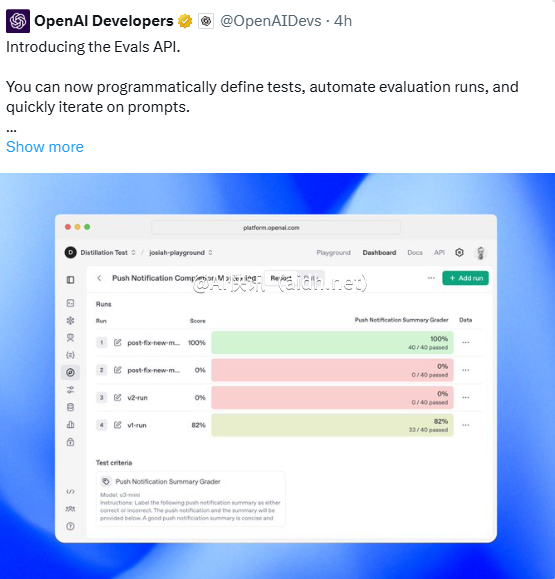

近期,领先的人工智能公司OpenAI正式推出了Evals API,这一全新工具的推出立即引起了开发者和技术圈的广泛关注。据介绍,Evals API支持用户通过编程方式定义测试、自动化运行评估流程,并优化提示的迭代过程。这一新功能的发布不仅将模型评估从手动操作转变为高度自动化的新阶段,还为开发者提供了更加灵活、高效的工具,以加速人工智能应用的开发和优化。

Evals API的核心特点在于其程序化属性。过去,开发者在测试和评估人工智能模型时通常依赖OpenAI提供的仪表板界面,手动输入测试用例并记录结果。但是现在,通过Evals API,开发者可以直接在代码中定义测试逻辑,利用脚本自动运行评估任务,并实时获取结果反馈。这种方式不仅显著提升了效率,还允许将评估流程无缝地融入到当前的开发工作流中。举例来说,一个团队可以将Evals API整合到持续集成/持续部署(CI/CD)管道中,自动验证模型更新后的性能表现,确保每次迭代都符合预期标准。

此外,Evals API的推出也为提示工程带来了新的机遇。开发者可以通过快速迭代提示,测试不同输入对模型输出的影响,以找到最佳的指令组合。这一功能尤其适用于需要微调模型行为的场景,比如智能客服、教育助手或代码生成工具。行业人士指出,这种程序化的测试方法将大幅缩短优化周期,帮助开发者更快地将人工智能模型投入生产环境。

技术分析显示,Evals API背后依托了OpenAI在模型评估框架方面的深厚积累。OpenAI之前曾开源其Evals框架,用于内部测试GPT系列模型的性能,而现在推出API则进一步向外部开发者开放了这一技术。结合API强大的功能,开发者不仅可以评估模型的准确性,还能通过定制的指标跟踪模型在特定任务中的表现,比如语言生成质量、逻辑推理严密性或多模态任务的协同能力。

值得注意的是,Evals API并未取代原有的仪表板功能,而是作为一项补充,为用户提供更多选择。对于习惯使用图形界面的用户,仪表板仍然是直观易用的评估工具;对于需要深度定制和自动化的大型项目,API则展示出无可比拟的优势。专家预测,这种双轨并行策略将进一步扩大OpenAI平台的用户群,个人开发者和企业团队都将从中受益。

然而,随着这一技术的推出也伴随着一些潜在挑战。自动化评估虽然高效,但如何设计科学合理的测试用例,以及如何解读复杂的评估结果,仍需要开发者具备一定的专业知识。此外,频繁调用API可能增加计算成本,尤其对于大规模测试项目而言,资源管理将成为一个需要关注的焦点。

作为人工智能技术领域中的又一里程碑,OpenAI发布Evals API为开发者生态带来了新的动力。从智能应用的快速原型设计到企业级人工智能系统的性能验证,这一工具正在以程序化的方式重新定义模型测试的未来。可以预见,随着Evals API的普及,人工智能开发的效率和质量将迎来新的飞跃,而OpenAI也将进一步巩固其在全球技术竞争中的领先地位。

快讯中提到的AI工具

致力于创造对全人类有益的安全 AGI